Meta wprowadza Llama Stack, aby ułatwić programistom budowanie aplikacji opartych na modelach językowych Llama. To odpowiedź na rosnące zapotrzebowanie na standaryzację w inżynierii sztucznej inteligencji. Llama Stack to zestaw narzędzi i interfejsów API, który ma uprościć wdrażanie i zarządzanie dużymi modelami językowymi (LLM).

Llama Stack – nowa era dla programistów

Na konferencji Meta Connect 2024, Meta ogłosiła premierę Llama 3.2, najnowszego modelu językowego z rodziny Llama. Firma, kierowana przez Chrisa Coxa, wiceprezesa ds. produktów, stawia na ułatwienie pracy programistom, oferując narzędzia, które mają uprościć korzystanie z tych zaawansowanych modeli. Llama Stack to odpowiedź na liczne opinie programistów, którzy zwracali uwagę, że praca z wcześniejszymi wersjami modeli Llama była zbyt skomplikowana i czasochłonna.

Cox podczas swojego wystąpienia zaznaczył, że wcześniejsze wersje, takie jak Llama 1, 2 i 3.1, skupiały się głównie na wydajności modelu. Jednak tym razem uwaga została przeniesiona na potrzeby programistów, którzy potrzebują bardziej zintegrowanych narzędzi do efektywnego tworzenia aplikacji AI.

Czym jest Llama Stack?

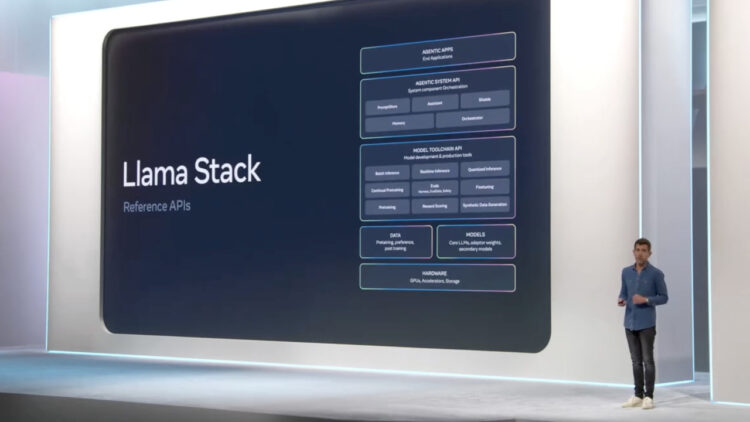

Llama Stack to zestaw referencyjnych API, które obejmują wszystkie kluczowe elementy nowoczesnych systemów AI opartych na dużych modelach językowych. To kompleksowe rozwiązanie składa się z bibliotek, które można łatwo zintegrować z popularnymi środowiskami programistycznymi, takimi jak PyTorch. Meta przygotowała to narzędzie, aby przyspieszyć i usprawnić proces budowy aplikacji AI, eliminując konieczność ręcznego konfigurowania każdego elementu systemu.

Llama Stack dostarcza programistom gotowe „klocki” do budowy aplikacji, które obejmują następujące API:

– Inference (wnioskowanie)

– Safety (bezpieczeństwo)

– Memory (pamięć)

– Agentic System (system agentowy)

– Evaluation (ewaluacja)

– Post Training (poszkoleniowe)

– Synthetic Data Generation (generowanie danych syntetycznych)

– Reward Scoring (ocena nagród)

Każde z tych API to zestaw punktów końcowych REST, co oznacza, że mogą one być obsługiwane przez dostawców chmurowych lub dedykowane serwisy inference. Dzięki temu programiści mogą łatwo integrować różne komponenty, bez konieczności martwienia się o zaplecze techniczne.

Dostępność i integracja

Meta zadbała o to, aby Llama Stack można było łatwo uruchomić w wielu środowiskach. Obecnie dostępne są trzy główne dystrybucje na Dockerze: lokalna GPU, lokalna CPU oraz Local TGI + Chroma. To pozwala programistom na szybkie rozpoczęcie pracy w zależności od dostępnych zasobów sprzętowych.

Jak podkreśla Ahmad Al-Dahle, lider generatywnej AI w Meta, Llama Stack Distribution to ogromny krok naprzód w obsłudze programistów. Celem jest zapewnienie jednolitego środowiska, które będzie działało zarówno lokalnie, jak i w chmurze, czy nawet na urządzeniach mobilnych.

Agentic System API – klucz do przyszłości

Jednym z najważniejszych elementów Llama Stack jest API systemu agentowego, które zyskuje coraz większe zainteresowanie wśród społeczności programistów AI. Meta wykorzystuje termin „agenticzne aplikacje”, aby opisać oprogramowanie, które będzie budowane za pomocą tych narzędzi. Aplikacje te są w stanie wykonywać skomplikowane zadania, rozbijać je na mniejsze kroki i wykorzystywać zewnętrzne narzędzia do realizacji działań.

W repozytorium GitHub Meta zaprezentowała przykłady aplikacji zbudowanych na bazie Llama Stack, które już teraz potrafią:

– Rozbijać zadania na mniejsze kroki przy wieloetapowym wnioskowaniu.

– Używać narzędzi do działania, zarówno wbudowanych jak i definiowanych ad-hoc.

– Zapewniać systemowy poziom ochrony dzięki modelom takim jak Llama Guard.

Standardyzacja narzędzi AI

Llama Stack to kolejny krok w kierunku standaryzacji narzędzi do budowy aplikacji AI. Korzystanie z Llama Stack w połączeniu z modelami Llama stanowi alternatywę dla narzędzi takich jak LangChain lub LlamaIndex, które wymagają ręcznej integracji z innymi modelami znajdującymi się w repozytoriach, takich jak Hugging Face. Dzięki Llama Stack wszystkie te decyzje są podejmowane automatycznie, co znacznie ułatwia i przyspiesza pracę programistów.

Podsumowanie

Llama Stack to odpowiedź na potrzeby współczesnej inżynierii AI. Meta udostępnia programistom zestaw narzędzi, który nie tylko upraszcza pracę z modelami Llama, ale również standaryzuje proces budowy aplikacji AI. Czas pokaże, jakie innowacyjne aplikacje powstaną dzięki tym narzędziom, ale jedno jest pewne – Llama Stack to krok naprzód w kierunku bardziej zintegrowanej i dostępnej inżynierii sztucznej inteligencji.