Uwaga redakcji: Ten artykuł jest częścią serii AI Decoded, której celem jest uproszczenie zagadnień związanych ze sztuczną inteligencją poprzez ich przybliżenie użytkownikom, a także prezentacja nowych narzędzi sprzętowych, oprogramowania oraz akceleratorów dla użytkowników komputerów PC GeForce RTX i stacji roboczych NVIDIA RTX.

Seria AI Decoded przez cały ostatni rok zgłębiała tematy związane z AI — od demistyfikacji skomplikowanych modeli językowych (LLM), po ukazywanie możliwości komputerów i stacji roboczych napędzanych technologią RTX AI.

Podsumowując najnowsze osiągnięcia AI, niniejszy artykuł przedstawia, jak technologia zmieniła sposób, w jaki ludzie piszą, grają, uczą się i łączą w sieci.

blank” href=”https://www.nvidia.com/en-us/data-center/tensor-cores/”>rdzenie Tensor, oferują ponad 1,3 biliona operacji na sekundę (TOPS) w celu zapewnienia najwyższej wydajności w grach, tworzeniu, codziennej produktywności i nie tylko. Dla stacji roboczych karty NVIDIA RTX przekraczają 1,4 biliona TOPS, umożliwiając przyspieszenie i efektywność na zupełnie nowym poziomie.

Uwolnij produktywność i kreatywność dzięki chatbotom zasilanym przez AI

Wcześniejsze publikacje z cyklu AI Decoded przybliżyły, czym są modele językowe (LLM), dlaczego są istotne i jak z nich korzystać.

Dla wielu osób narzędzia takie jak ChatGPT były pierwszym zetknięciem się z AI. Dzięki LLM-om chatboty przekształciły interakcje komputerowe z podstawowych działań opartych na regułach w dynamiczne rozmowy. Mogą one proponować pomysły na wakacje, pisać e-maile z obsługi klienta, tworzyć oryginalne wiersze, a nawet pisać kod dla użytkowników.

W marcu zaprezentowano ChatRTX — aplikację demonstracyjną, która pozwala użytkownikom spersonalizować GPT LLM przy użyciu własnych treści, takich jak dokumenty, notatki czy obrazy.

Dzięki funkcjom, takim jak generowanie wspomagane wyszukiwaniem (RAG), NVIDIA TensorRT-LLM oraz akceleracji RTX, ChatRTX umożliwia użytkownikom szybkie wyszukiwanie i zadawanie pytań dotyczących ich własnych danych. Co więcej, aplikacja działa lokalnie na komputerach PC lub stacjach roboczych RTX, co zapewnia zarówno szybkie wyniki, jak i pełną prywatność.

NVIDIA oferuje najszerszy wybór fundamentalnych modeli zarówno dla entuzjastów, jak i programistów, w tym Gemma 2, Mistral czy Llama-3. Modele te można uruchamiać lokalnie na kartach GeForce i RTX, co zapewnia szybkie i bezpieczne działanie, bez konieczności korzystania z usług w chmurze.

Wprowadzenie aplikacji z funkcjami AI przyspieszanymi przez RTX

Sztuczna inteligencja jest wprowadzana do coraz większej liczby aplikacji i przypadków użycia, w tym gier, programów do tworzenia treści, narzędzi programistycznych i aplikacji zwiększających produktywność.

Ten rozwój jest napędzany szerokim wyborem narzędzi deweloperskich i społecznościowych przyspieszanych przez RTX, zestawów SDK, modeli oraz frameworków, które umożliwiają łatwe uruchamianie modeli lokalnie w popularnych aplikacjach.

W październiku AI Decoded zaprezentowało, jak funkcja Leo AI w przeglądarce Brave, zasilana kartami RTX firmy NVIDIA oraz platformą open-source Ollama, pozwala użytkownikom uruchamiać lokalne modele LLM, takie jak Llama 3, bezpośrednio na komputerach lub stacjach roboczych RTX.

Lokalne środowisko zapewnia szybkie i responsywne działanie SI, jednocześnie chroniąc dane użytkownika dzięki braku konieczności korzystania z usług w chmurze. Optymalizacje NVIDIA dla narzędzi, takich jak Ollama, oferują przyspieszoną wydajność w zadaniach, takich jak podsumowanie artykułów, odpowiadanie na pytania czy wydobywanie kluczowych informacji — wszystko w ramach przeglądarki Brave.

Sztuczna inteligencja agentowa — nowe możliwości rozwiązywania złożonych problemów

Agentowa AI to kolejna granica rozwoju sztucznej inteligencji. Jest zdolna do wykorzystania zaawansowanego rozumowania oraz planowania iteracyjnego, aby samodzielnie rozwiązywać złożone, wieloetapowe problemy.

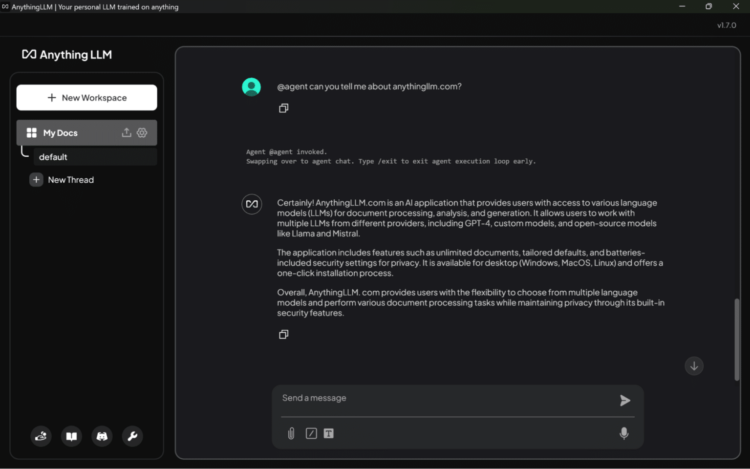

Zastosowania takie jak AnythingLLM pokazują, jak SI wychodzi poza prostą odpowiedź na pytania, poprawiając produktywność i kreatywność. Użytkownicy mogą korzystać z tej aplikacji do wdrażania wbudowanych agentów zdolnych do wykonywania takich zadań, jak przeszukiwanie internetu czy organizowanie spotkań.

AnythingLLM działa lokalnie, jest szybkie, prywatne oraz umożliwia wykorzystywanie danych i narzędzi niedostępnych w rozwiązaniach chmurowych, dzięki czemu tworzy środowisko wspomagające eksperymentowanie i innowacje w technologii agentowej AI.

Podsumowanie w ramach AI Decoded

Obecnie ponad 600 aplikacji dla systemu Windows oraz gier działa lokalnie dzięki AI na ponad 100 milionach komputerów i stacji roboczych GeForce RTX na całym świecie. Te rozwiązania dostarczają szybkich, niezawodnych i niskolatencyjnych doświadczeń użytkownikom różnych środowisk.

Sztuczna inteligencja zmienia sposób, w jaki pracujemy, uczymy się i bawimy, a dzięki kolejnym innowacjom jej zastosowania stają się jeszcze szersze. Aby być na bieżąco z tym, co nowe i przyszłościowe, warto śledzić najnowsze wydarzenia i zapowiedzi w zakresie AI, takie jak przemówienie otwierające na targach CES, które odbędzie się już 6 stycznia.