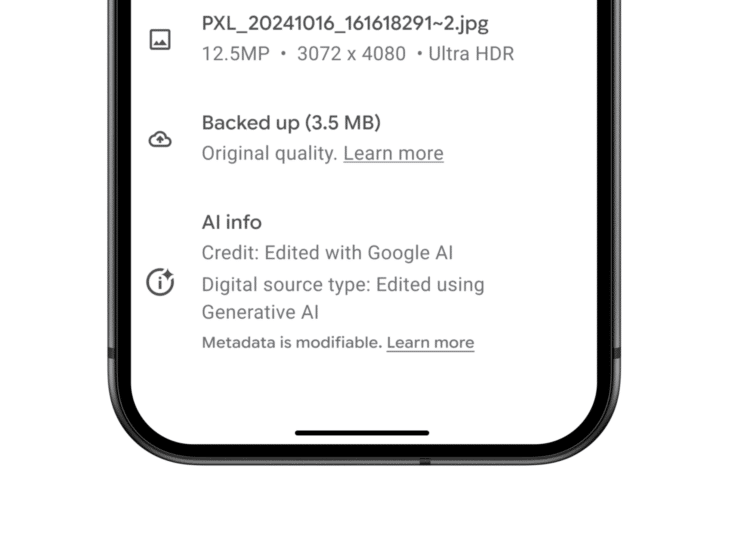

Od przyszłego tygodnia aplikacja Google Photos wprowadzi nową funkcję informującą, kiedy zdjęcie zostało edytowane za pomocą jednej z narzędzi sztucznej inteligencji (AI), takich jak Magic Editor, Magic Eraser czy Zoom Enhance. Informacja ta pojawi się w sekcji „Szczegóły” (Details) pod zdjęciem, gdzie znajdziemy adnotację o edycji przeprowadzonej za pomocą technologii Google AI. To krok mający na celu zwiększenie transparentności w obszarze edytowania zdjęć z wykorzystaniem zaawansowanych narzędzi sztucznej inteligencji.

Nowy poziom przejrzystości, choć nadal niepełny

Google podkreśla, że wprowadzenie tej funkcji ma na celu „dalsze zwiększenie przejrzystości”, ale mimo to, dla przeciętnego użytkownika może nie być od razu oczywiste, że zdjęcie było edytowane przez AI. Choć informacja o edycji będzie dostępna w metadanych zdjęcia, nie pojawią się żadne widoczne znaki wodne na samym obrazie, które od razu sugerowałyby, że dany obraz jest generowany lub modyfikowany przez sztuczną inteligencję. Oznacza to, że ktoś przeglądający zdjęcia na mediach społecznościowych, w aplikacjach wiadomościowych lub nawet w galerii swojego telefonu, nie zauważy od razu, że zdjęcie jest wynikiem działania AI.

Dlaczego Google zdecydowało się na ten krok?

Pomysł wprowadzenia tego rodzaju oznaczeń pojawił się po fali krytyki, jaka spadła na Google po udostępnieniu zaawansowanych narzędzi opartych na sztucznej inteligencji bez wyraźnych oznaczeń wizualnych, które byłyby łatwo czytelne dla użytkowników. Wprowadzenie tych narzędzi w sierpniu 2024 roku w ramach premiery serii telefonów Pixel 9, które zostały wyposażone w szereg nowych funkcji AI do edycji zdjęć, wywołało obawy co do problemu dezinformacji wizualnej w sieci. W odpowiedzi na te obawy, Google zdecydowało się wprowadzić bardziej widoczne oznaczenia.

Jednakże, choć Google podjęło działania w celu poprawy przejrzystości, wielu użytkowników nadal oczekuje bardziej bezpośrednich komunikatów w formie znaków wodnych na samych zdjęciach. Obecnie oznaczenia AI są dodawane jedynie do metadanych pliku, co dla przeciętnej osoby nie jest zbyt intuicyjne. Aby odkryć, że zdjęcie zostało zmodyfikowane przez AI, użytkownik musi samodzielnie zlokalizować i sprawdzić sekcję „Szczegóły” zdjęcia.

Problem braku widocznych znaków wodnych

Choć metadane zawierają informacje o edycji zdjęcia przez AI, wielu użytkowników oczekuje bardziej czytelnych znaków wodnych, które byłyby widoczne na pierwszy rzut oka. Niestety, Google na razie nie zamierza wprowadzać tego typu rozwiązań, mimo że nie wyklucza takich działań w przyszłości. Michael Marconi, menedżer ds. komunikacji Google Photos, poinformował, że firma nadal pracuje nad rozwojem tej funkcji, zbiera opinie użytkowników i będzie kontynuować doskonalenie narzędzi mających na celu poprawę przejrzystości.

Oczywiście, wprowadzenie widocznych znaków wodnych również nie jest idealnym rozwiązaniem. Takie oznaczenia mogłyby być łatwo usuwane poprzez dalszą edycję zdjęcia – np. przez przycięcie obrazu – co ponownie utrudniłoby identyfikację, czy dane zdjęcie zostało zmodyfikowane za pomocą narzędzi AI.

Jakie są dalsze kroki Google i innych platform?

Rosnąca popularność narzędzi AI do edytowania zdjęć, takich jak te oferowane przez Google, może zwiększyć ilość syntetycznych treści, które użytkownicy oglądają w sieci. To z kolei spowoduje, że coraz trudniej będzie odróżnić, co jest prawdziwe, a co sztucznie wygenerowane. Google zamierza flagować obrazy generowane przez sztuczną inteligencję w swoich wynikach wyszukiwania jeszcze w tym roku, a podobne kroki podejmuje już Meta na Facebooku i Instagramie.

Jednak nie wszystkie platformy są tak szybkie we wdrażaniu podobnych rozwiązań, co budzi obawy o to, jak duży wpływ na użytkowników może mieć masowe rozpowszechnianie treści generowanych przez AI. W miarę, jak technologia ta będzie się rozwijać, nieuniknione jest, że pojawią się pytania o to, jak skutecznie oznaczać tego typu treści, by użytkownicy mieli pełną świadomość, co dokładnie oglądają.

Podsumowanie

Wprowadzenie nowych oznaczeń w Google Photos to krok w stronę większej przejrzystości, ale jak dotąd nie jest to rozwiązanie idealne. Brak widocznych znaków wodnych na zdjęciach stwarza ryzyko, że użytkownicy nie będą świadomi, że oglądają zmodyfikowane obrazy, co wprowadza w błąd i może przyczynić się do dalszej dezinformacji wizualnej w sieci. Google obiecuje dalsze prace nad tym zagadnieniem, jednak przed nami wciąż wiele wyzwań związanych z kontrolowaniem treści generowanych przez AI.