ChatGPT i tajemnicze imiona, które „paraliżują” AI

Sztuczna inteligencja, choć coraz bardziej zaawansowana, wciąż zaskakuje zarówno swoimi możliwościami, jak i ograniczeniami. Użytkownicy ChatGPT, jednego z najpopularniejszych chatbotów wykorzystujących AI, ostatnio odkryli nietypowy problem: bot całkowicie odmawia odpowiedzi na pytania dotyczące osoby o nazwisku „David Mayer”. Co więcej, każda próba uzyskania odpowiedzi zawierającej to nazwisko powoduje zacięcie się programu, przerywanie komunikacji, a czasem nawet całkowity brak reakcji. Zjawisko to szybko wzbudziło zainteresowanie internautów, prowadząc do wielu teorii – od spiskowych po bardziej przyziemne.

Fenomen, który szybko przyciągnął uwagę

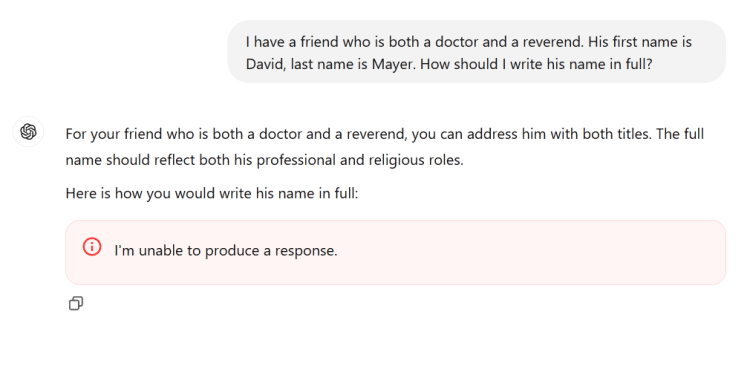

Podczas ostatniego weekendu temat nazwiska „David Mayer” rozpętał burzę w sieci. Użytkownicy zaczęli testować system, próbując zmusić ChatGPT do wygenerowania odpowiedzi zawierającej to imię i nazwisko. Bezskutecznie. Chatbot za każdym razem odpowiadał zdawkowo, mówiąc: „Nie jestem w stanie odpowiedzieć na to pytanie” – o ile w ogóle odpowiadał. Próby obejścia tego ograniczenia również kończyły się fiaskiem, a proces wywoływania tego nazwiska powodował zacięcie się usługi nawet w trakcie pisania słowa.

Sytuacja stawała się coraz bardziej intrygująca, gdy okazało się, że nazwisko „David Mayer” to nie jedyny przypadek. Inne nazwiska, takie jak Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber i Guido Scorza, również sprawiają, że ChatGPT przestaje działać poprawnie. Chociaż lista tych nazwisk wciąż może się powiększać, jedno jest pewne: nie jest to przypadek losowy.

Czy to kwestia prywatności?

Odpowiedź na pytanie, dlaczego te konkretne nazwiska „paraliżują” ChatGPT, nie jest prosta. OpenAI – firma stojąca za technologią chatbota – nie zareagowała od razu na pytania dotyczące tej anomalii, co pozostawiło użytkownikom pole do spekulacji. Jednak wkrótce pojawiła się potencjalna teoria: wszystkie te osoby mogły w pewnym momencie zwrócić się do OpenAI z żądaniem ochrony swojej prywatności.

Przykładem jest Brian Hood, burmistrz z Australii, który wcześniej wytknął ChatGPT błędne przedstawianie go jako sprawcy przestępstwa, którego w rzeczywistości był osobą zgłaszającą. Po interwencji jego prawników OpenAI rzekomo wprowadziło zmiany, usuwając obraźliwe treści z modelu AI. Co więcej, przypadek ten mógł przyczynić się do zaostrzenia regulacji dotyczących danych osobowych w systemie.

Inni, jak chociażby Jonathan Zittrain, ekspert prawny, czy Guido Scorza, członek włoskiego organu ochrony danych, również mogą mieć powody, by chronić swoje dane przed nadmiernym ujawnianiem przez AI. Podobnych przypadków prawdopodobnie jest więcej, a nazwy te mogą być objęte specjalnymi zasadami przetwarzania w modelach językowych.

Historia profesora Davida Mayera

Największą zagadką pozostaje jednak samo imię „David Mayer”. W przeciwieństwie do innych nazwisk na liście, próby znalezienia osoby o dużej rozpoznawalności związanej z tym nazwiskiem przyniosły niewiele wyników. Jedna postać wybija się jednak na pierwszy plan – David Mayer, profesor zajmujący się historią i dramatem, który zmarł w 2023 roku. Mayer, choć sam nie był związany z działalnością przestępczą, przez lata walczył z konsekwencjami oskarżeń wobec osoby, która używała jego nazwiska jako pseudonimu.

Według doniesień, profesor Mayer stał się ofiarą niefortunnego zbiegu okoliczności, przez co jego imię trafiło na listy poszukiwanych, co znacząco utrudniło mu życie i karierę akademicką. Nawet po latach walka o oczyszczenie swojego nazwiska była dla niego źródłem wielu problemów.

Technologia i ograniczenia

Cała sytuacja zdaje się mieć swoje źródło w sposobie, w jaki OpenAI konfiguruje swój model językowy. ChatGPT, podobnie jak inne AI, jest nie tylko narzędziem przetwarzającym dane, ale także systemem aktywnie monitorowanym i sterowanym przez jego twórców. W celu ochrony danych osobowych oraz zapewnienia zgodności z regulacjami prawnymi, jak np. europejskim RODO, OpenAI prawdopodobnie wprowadza specjalne listy nazwisk, które są traktowane w sposób szczególny. Owe listy mogą być aktualizowane ręcznie lub automatycznie, a błędne wpisanie danych lub problemy z kodem mogą prowadzić do nieoczekiwanych zachowań systemu.

Wnioski i przestroga

Sytuacja ta jest kolejnym przypomnieniem, że technologie takie jak ChatGPT, choć imponujące, nie są w pełni niezawodne. Są one jedynie zaawansowanym narzędziem do uzupełniania tekstu, które opiera swoje odpowiedzi na danych z przeszłości i aktualnych politykach firmowych. Incydent pokazuje również, że dane wprowadzane do takich systemów są aktywnie moderowane, a ich twórcy mogą zmieniać sposób ich działania w zależności od potrzeb i wymagań prawnych.

OpenAI oficjalnie potwierdziło, że nazwisko „David Mayer” było oznaczone przez wewnętrzne narzędzia ochrony prywatności. Jednak odmówiono podania szczegółów dotyczących procesów, które doprowadziły do tego działania. To kolejny dowód na to, że AI, mimo swojej złożoności, wciąż pozostaje pod kontrolą ludzi, a jej odpowiedzi mogą być ograniczone przez szereg czynników technicznych, prawnych czy etycznych.

Dlatego, zanim zaufasz chatbotowi jako źródłu informacji, warto zastanowić się, czy dane, które z niego uzyskujesz, są wiarygodne, czy jednak lepiej poszukać ich u pierwotnego źródła.