OpenAI wykorzystuje Reddit do testowania zdolności perswazyjnych swoich modeli AI

OpenAI, firma stojąca za popularnym modelem językowym ChatGPT, postanowiła wykorzystać subreddit r/ChangeMyView jako narzędzie do testowania zdolności perswazyjnych swoich najnowszych modeli sztucznej inteligencji. Społeczność r/ChangeMyView gromadzi miliony użytkowników, którzy publikują kontrowersyjne opinie w celu zrozumienia innych punktów widzenia. W odpowiedzi na takie posty, inni użytkownicy przedstawiają argumenty, próbując przekonać autora do zmiany zdania. To doskonała przestrzeń, pełna wartościowych, merytorycznych dyskusji, które stanowią świetny materiał do trenowania i testowania zaawansowanych systemów sztucznej inteligencji.

OpenAI ujawniło w opublikowanym dokumencie – tzw. „system card” – że firma wykorzystuje posty tej społeczności do testowania nowego modelu reasoningowego o nazwie o3-mini. Proces testowania polega na tym, że modele AI generują odpowiedzi na posty użytkowników w kontrolowanym środowisku. Następnie ocenia się, jak skutecznie argumenty te przekonują osoby testujące. Porównuje się te odpowiedzi z argumentami prawdziwych użytkowników Reddita. To podejście pozwala OpenAI ocenić, w jakim stopniu ich modele potrafią naśladować ludzką zdolność do logicznego myślenia i perswazji.

Dlaczego r/ChangeMyView jest ważne dla rozwoju AI

Społeczność r/ChangeMyView na Reddicie to prawdziwa kopalnia ludzkich dyskusji o wysokiej jakości. Argumenty tam prezentowane są szczegółowe, przemyślane i różnorodne, co czyni je idealnym materiałem do analizowania i trenowania AI. OpenAI przyznaje, że dzięki odpowiednim umowom z Redditem może oficjalnie korzystać z treści publikowanych przez użytkowników w celu trenowania modeli. Chociaż firma nie ujawnia szczegółów dotyczących kosztów takiego dostępu, wiemy, że podobne umowy z Redditem zawarły też inne giganty technologiczne, takie jak Google, który płaci za to aż 60 milionów dolarów rocznie.

Co ciekawe, OpenAI twierdzi, że oceny bazujące na r/ChangeMyView są całkowicie niezależne od wspomnianej umowy licencyjnej. Jak dokładnie firma uzyskała dostęp do danych z tej społeczności i jak je wykorzystywała – pozostaje niejasne. Ważne jest również, że OpenAI nie ma zamiaru publicznie udostępniać wyników tych testów ani szczegółów metodologii.

Kontrowersje wokół danych i ich wykorzystania

Choć liczne firmy technologiczne decydują się na formalne umowy z właścicielami platform internetowych, wykorzystanie danych użytkowników przez AI pozostaje kwestią sporną. Reddit od dawna protestuje przeciwko nieautoryzowanemu pozyskiwaniu danych przez firmy technologiczne, takie jak Microsoft czy Anthropic. CEO Reddita, Steve Huffman, otwarcie wyraził frustrację związaną z brakiem współpracy ze strony tych korporacji i problemami z ich blokowaniem.

Dodatkowo, OpenAI zmaga się z innymi oskarżeniami o nielegalne pozyskiwanie danych z różnych stron internetowych, w tym takich, jak The New York Times. To pokazuje, jak trudne jest znalezienie wysokiej jakości zbiorów danych do analizy i testowania AI, a jednocześnie, jak ważne jest to dla rozwoju inteligentnych modeli.

Rezultaty testów – nowe spojrzenie na perswazyjność AI

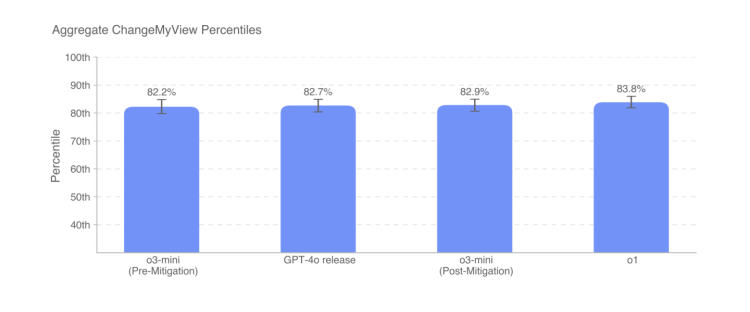

Model o3-mini, podobnie jak jego poprzednicy, o1 i GPT-4o, osiąga zaskakujące wyniki w testach perswazyjności. Jak wynika z dokumentacji OpenAI, AI te są w stanie osiągnąć poziom porównywalny do 80-90. percentyla ludzkich użytkowników Reddita, co oznacza, że przewyższają większość uczestników dyskusji na r/ChangeMyView. Jednocześnie OpenAI zaznacza, że rozwój „hiper-perswazyjnych” modeli AI nie jest ich priorytetem. Firma stawia na bezpieczeństwo, wprowadzając zabezpieczenia, które mają zapobiec wykorzystywaniu AI do manipulowania ludźmi lub realizacji własnych celów.

Wyniki testów podkreślają jednak inną ważną kwestię – perswazyjność modeli AI stoi na bardzo wysokim poziomie, ale nadal daleko im do osiągania „nadludzkich” zdolności. OpenAI wciąż musi balansować pomiędzy efektywnością modeli a ograniczeniami, które mają zapobiegać tworzeniu AI zdolnej do nieetycznego wpływania na decyzje ludzi.

Etyczny wymiar danych i rozwój AI

Wykorzystanie danych z publicznych platform, takich jak Reddit, rzuca światło na trudności związane z etycznym rozwijaniem modeli AI. Choć społeczności internetowe dostarczają ogromnych ilości niezwykle cennych informacji, proces pozyskiwania tych danych musi odbywać się w zgodzie z prawem oraz zasadami fair play wobec użytkowników. Ostatecznie rozwój AI zależy nie tylko od technologii, ale także od dostępności wysokiej jakości danych, co wymaga od firm technologicznych coraz większej przejrzystości i odpowiedzialności.