16 grudnia 2025 — David Eastman. Czas czytania: około 5 minut.

W ciągu najbliższych kilku lat dostawcy dużych modeli językowych (LLM) będą musieli rozwiązać obecne ograniczenia technologii: wysokie koszty energetyczne, skłonność do tzw. halucynacji (wytwarzania nieprawdziwych informacji) oraz rosnące zużycie tokenów przy próbach uzyskania precyzyjnych odpowiedzi. Ten tekst przegląda realistyczne kierunki rozwoju — od lepszych struktur wiedzy, przez modele współdzielone, aż po przeniesienie części funkcji lokalnie na urządzenia użytkowników — tłumacząc, co to oznacza zarówno dla firm oferujących LLM, jak i dla zwykłych użytkowników i deweloperów.

Dlaczego LLM potrzebują zmiany

LLM sprawdzają się w konwersacyjnym formacie, lecz ich koszty operacyjne i problem z halucynacjami hamują dalszą ekspansję. Nie jest do końca jasne, jak wielkość modelu i sposób treningu przekładają się na ostateczne zachowanie, a to utrudnia skalowanie „na oślep”. W praktyce oznacza to, że firmy muszą znaleźć sposoby na poprawę jakości i efektywności bez bezwzględnego zwiększania rozmiarów modeli.

Warto też odnieść się do krytycznej opinii Yann’a LeCun’a, który stwierdził, że LLM mogą być „ślepą uliczką” w drodze do sztucznej ogólnej inteligencji. Nawet jeśli jego przewidywanie dotyczące AGI się sprawdzi, ogromne inwestycje i momentum przemysłu sprawiają, że LLM pozostaną istotne jeszcze przez długi czas. Sam LeCun — jak wiadomo — uruchomił też startup, by kontynuować badania nad zaawansowaną inteligencją maszynową, ale efekty takich przedsięwzięć pojawiają się zwykle dopiero po latach.

Ontologie i grafy wiedzy — uporządkowanie informacji

Wczesne podejścia do sztucznej inteligencji zakładały tworzenie dużych ontologii — formalnych map pojęć, które porządkują wiedzę. LLM uczą się na masywnych zbiorach danych i „wewnętrznie” powiązują pojęcia w sposób mniej uporządkowany niż klasyczne ontologie. Mimo to LLM potrafią wspomagać tworzenie grafów wiedzy, a techniki takie jak Retrieval‑Augmented Generation (RAG) są już stosowane, by „uziemić” odpowiedzi modelu, dostarczając mu sformatowane, eksperckie źródła.

Jednym z kierunków przeciwdziałania halucynacjom może być utrzymanie i współdzielenie obszernych, tematycznych grafów wiedzy zarządzanych przez zewnętrzne podmioty — swoiste „encyklopedie” w danej dziedzinie. Presja regulacyjna może wymusić takie rozwiązania: przykładem jest niedawne wprowadzenie przez Australię ograniczeń wiekowych na media społecznościowe z powodu negatywnych skutków uzależnienia od ekranu u dzieci. W podobnym tonie można wyobrazić sobie wymóg stosowania kontrolowanych, bezpiecznych zbiorów wiedzy (autorstwa zaufanych stron trzecich) w systemach odpowiadających na zapytania publiczne, aby ograniczyć rozpowszechnianie stronniczych lub niezweryfikowanych informacji.

Model „hub and spoke” i protokoły współpracy

Współdzielenie dużych zasobów wiedzy może stać w sprzeczności z modelami biznesowymi konkurujących dostawców, ale współpraca przynosi oszczędności i praktyczne korzyści. Przykładem jest szerokie, szybkie przyjęcie Model Context Protocol (MCP) zaproponowanego przez Anthropic — porównywane w tekście do „USB dla LLM”. Tam, gdzie rozwiązanie jest praktyczne, konkurencja często je adaptuje.

OpenAI pokazało też, jak można model dystrybucji łączyć z lokalnymi źródłami wiedzy: poprzez Apps SDK i eksperymenty z przeglądarką Atlas firma testuje ideę, że model ogólny odpowiada na zapytania, ale w razie potrzeby odwołuje się do lokalnych serwerów aplikacji (czyli „serwerów MCP”) w celu uzyskania eksperckich informacji. W tym samym duchu pokazywano też mechanizmy pozwalające modelowi uzyskiwać dostęp do danych użytkownika lokalnie, np. do plików na dysku — co obrazuje, jak hybrydowe połączenie chmury i zasobów lokalnych może poprawić trafność i użyteczność odpowiedzi.

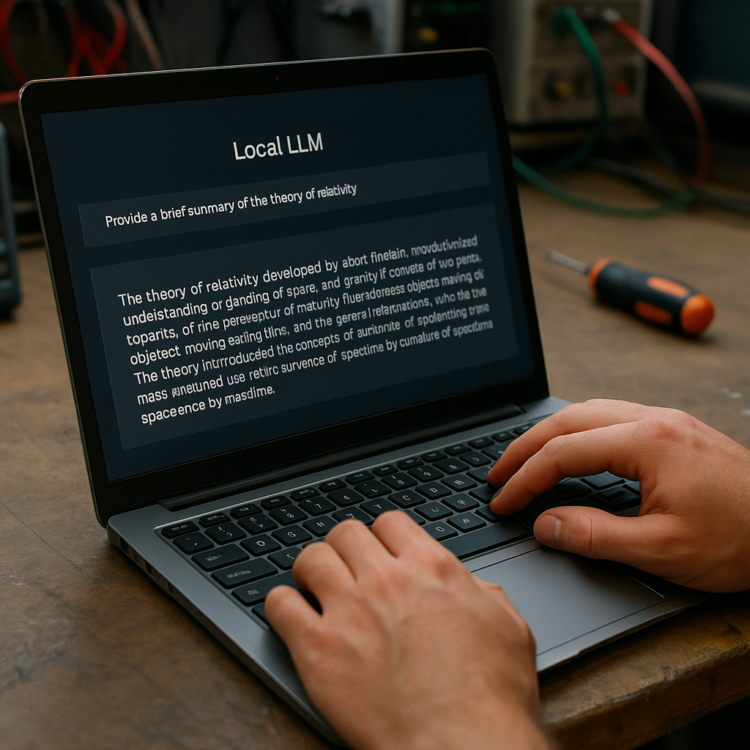

Modele lokalne — kiedy chmura nie jest konieczna

Część użytkowników już uruchamia LLM lokalnie — dostępne są mniejsze, wstępnie wytrenowane modele open source, które da się odpalić na laptopie, a w przyszłości coraz częściej na telefonie. Narzędzia takie jak Ollama upraszczają instalację i obsługę, chociaż pełne wykorzystanie lokalnych modeli wciąż wymaga pewnej wiedzy technicznej. Jednocześnie najpotężniejsze, „przewodowe” modele pozostaną w chmurze ze względu na koszty i wymagania obliczeniowe.

W praktyce pojawia się hybrydowy wzorzec: systemy agentowe (Agentic CLI) mogą wybierać szybki, tańszy model lokalny do prostych zadań i przekazywać „głębsze” zapytania do kosztowniejszych modeli chmurowych. To podejście zmniejsza zużycie zasobów i koszty, a jednocześnie utrzymuje jakość tam, gdzie jest ona kluczowa.

Strumień życia — kontekst osobisty jako wartość

Kolejnym powodem, by przenieść część funkcji na urządzenia użytkownika, jest dostęp do kontekstu osobistego. Dobre wyniki wyszukiwarek czy asystentów wynikają często z faktu, że znają one preferencje i historię użytkownika — dzięki temu eliminują nieistotne odpowiedzi. Firmy takie jak Amazon prawdopodobnie trenują modele na danych z systemów głosowych (Alexa) i rozpoznają różne osoby w jednym gospodarstwie domowym.

Lokalny LLM mógłby „słuchać” i analizować mowę oraz treści użytkownika, by lepiej rozumieć jego zainteresowania i kontekst geograficzny. Choć pomysł „aplikacji strumienia życia” budził obawy o nadzór i prywatność, to wielu użytkowników dobrowolnie dostarczało tego typu danych w poprzedniej dekadzie. Z punktu widzenia użyteczności, gromadzenie umiarkowanej ilości danych osobistych może stworzyć bogaty, spersonalizowany graf wiedzy, który znacznie poprawi trafność modelu. Jak przypomina autor, analiza życia w jakimś stopniu koresponduje ze stwierdzeniem Sokratesa, że „niezbadane życie nie jest warte przeżycia” — tu jednak chodzi o techniczny kontekst, nie o moralizowanie.

Podsumowanie

Możliwe, że dopiero korekta rynkowa (czyli też potencjalny „krach”) skłoni duże firmy do intensywnej pracy nad efektywnością i praktycznymi rozwiązaniami, a inwestorzy odwrócą się od wyścigu za „sztuczną ogólną inteligencją”. Nawet bez takiego szoku jest prawdopodobne, że kolejny etap rozwoju skoncentruje się na inżynierii: poprawie efektywności istniejących modeli, hybrydowych architekturach chmura–lokalnie oraz na mechanizmach zapewniających rzetelność i zgodność z regulacjami.

Dla osób korzystających z LLM w tworzeniu oprogramowania oznacza to, że zmiany będą widoczne „na żywo”: deweloperzy i zespoły inżynieryjne będą mieć pierwsze miejsce przy nadchodzących innowacjach i optymalizacjach, które zadecydują o praktycznej użyteczności modeli w codziennej pracy.