Czy Sztuczna Inteligencja Może Trenować Się Sama?

W obliczu rosnącego zapotrzebowania na dane treningowe dla modeli sztucznej inteligencji, pojawia się pytanie: czy modele AI mogą być efektywnie szkolone wyłącznie na danych syntetycznych generowanych przez inne modele AI? Choć pomysł ten może wydawać się abstrakcyjny, w rzeczywistości od dawna jest on przedmiotem badań i coraz częściej zyskuje na znaczeniu. W czasach, gdy dostęp do świeżych, wysokiej jakości danych staje się coraz trudniejszy, rozwiązania syntetyczne mogą okazać się potencjalną odpowiedzią na wiele wyzwań.

Dlaczego AI Potrzebuje Danych i Jakie Dane Są Kluczowe?

Modele sztucznej inteligencji są potężnymi maszynami statystycznymi, które uczą się na podstawie ogromnych ilości przykładów. Analizując dane, modele te identyfikują wzorce i wykorzystują je, by generować sensowne odpowiedzi lub przewidywania. Kluczowym elementem tego procesu są adnotacje – etykiety, które opisują zawartość danych i pomagają modelom rozpoznawać różnice między obiektami, miejscami czy ideami. Na przykład, model uczony na zdjęciach kuchni z etykietą „kuchnia” zacznie zauważać cechy charakterystyczne dla takich przestrzeni, jak obecność blatów czy lodówek.

Rynek adnotacji danych eksplodował w ostatnich latach, napędzany rosnącym zapotrzebowaniem na odpowiednio oznaczone dane. Usługi tego typu szacowane są obecnie na wartość 838,2 milionów dolarów, a prognozy mówią o wzroście do 10,34 miliarda dolarów w ciągu najbliższej dekady. Niestety, proces ten ma swoje ciemne strony. Pracownicy, zwłaszcza w krajach rozwijających się, często otrzymują niskie stawki za godziny monotonnej i wymagającej pracy bez żadnych dodatkowych świadczeń.

Wyłączność na Dane i Wysychające Zasoby

Jednym z głównych wyzwań związanych z szkoleniem modeli AI jest dostęp do danych. Wiele firm, takich jak Uber, zatrudnia całe zespoły ludzi do oznaczania swoich zbiorów treningowych, ale nawet takie podejście ma ograniczenia. Ludzie pracują z określoną szybkością, mają własne uprzedzenia, popełniają błędy, a koszt ich pracy znacząco odbija się na budżetach.

Do tego dochodzi problem dostępności danych. Właściciele treści coraz częściej ograniczają dostęp do swoich zasobów, obawiając się nieautoryzowanego wykorzystania czy braku odpowiedniego wynagrodzenia. Więcej niż 35% najpopularniejszych stron internetowych na świecie obecnie blokuje skrypty używane przez AI w celu zbierania danych. Co gorsza, według badań, około 25% treści o tzw. wysokiej jakości zostało wycofane z popularnych zestawów treningowych wykorzystywanych do szkolenia modeli. Jeśli ten trend się utrzyma, istnieje ryzyko, że między 2026 a 2032 rokiem programiści staną przed sytuacją, w której zabraknie im danych do trenowania modeli AI.

Syntetyczne Dane – Rozwiązanie na Problemy AI?

Produkowanie danych syntetycznych wydaje się być odpowiedzią na wiele problemów związanych z tradycyjnymi danymi. Potrzebujesz większej ilości przykładów czy oznaczeń? Wygeneruj je syntetycznie przy pomocy modeli AI. Pomysł ten błyskawicznie zyskał popularność w branży. W ostatnich miesiącach coraz więcej firm eksperymentuje z tą technologią.

Na przykład, firma Writer opracowała model Palmyra X 004, który został przeszkolony prawie w całości na danych syntetycznych. Koszt stworzenia tego modelu wyniósł jedynie 700 tysięcy dolarów, co stanowi ułamek kosztów, które ponoszą liderzy branży, tacy jak OpenAI. Podobne podejście przyjęły giganty technologiczne, takie jak Microsoft, Google czy Nvidia, które zaczęły intensywnie inwestować w rozwój technologii generujących dane syntetyczne.

Wyzwania z Syntetycznymi Danymi

Choć generowanie danych syntetycznych niesie obiecujące możliwości, nie jest wolne od problemów. Bazuje bowiem na modelach, które same mogą być obciążone błędami i uprzedzeniami. Z tego powodu dane syntetyczne odziedziczą te same ograniczenia, co oryginalne zbiory, na których zostały stworzone. Na przykład, jeśli w oryginalnych zbiorach brakuje reprezentacji mniejszości, dane syntetyczne również będą je pomijać.

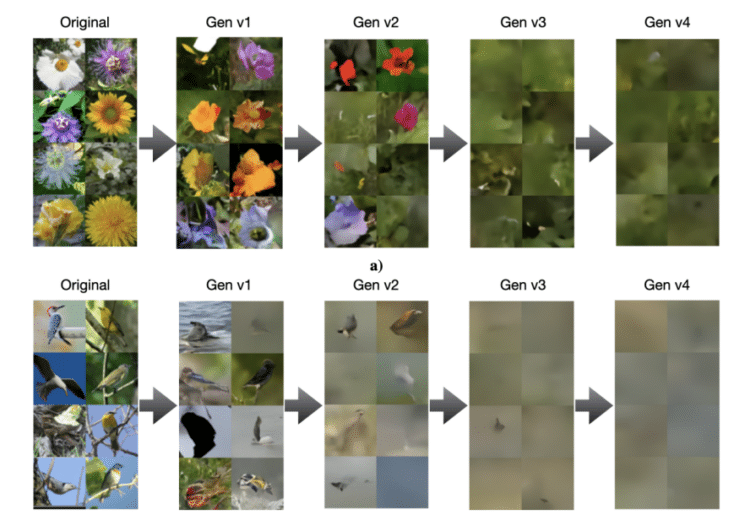

Ponadto, nadmierne poleganie na danych syntetycznych może prowadzić do tzw. „zapaści modeli”. Badania pokazują, że zbyt wiele iteracji treningu na syntetycznych zbiorach danych może skutkować coraz większym zubożeniem ich jakości. W wyniku tego modele stają się mniej różnorodne, bardziej „banalne” i podatne na błędy.

Szczególnie niebezpieczne wydaje się zjawisko halucynacji modeli AI – procesu, w którym systemy generują błędne lub nieistniejące informacje. Modele szkolone na takich danych mogą nie tylko reprodukować te błędy, ale też przyczyniać się do ich eskalacji, co obniża skuteczność przyszłych generacji AI.

Droga Naprzód: Łączenie Danych Syntetycznych z Rzeczywistymi

Eksperci są zgodni co do tego, że dane syntetyczne mogą być skutecznym narzędziem wspierającym rozwój AI, ale powinny być stosowane z rozwagą. Odpowiednie przeglądanie, filtrowanie i łączenie danych syntetycznych z rzeczywistymi zbiorami treningowymi może pomóc uniknąć niepożądanych efektów, takich jak zubożenie modeli czy zbyt silne uprzedzenia.

Sam Altman, CEO OpenAI, uważa, że w przyszłości AI będzie w stanie produkować syntetyczne dane dobrej jakości, które wystarczą do samodzielnego trenowania modeli. Jednak obecna technologia jeszcze nie osiągnęła tego poziomu zaawansowania. Dlatego na razie nie obejdzie się bez ludzkiego nadzoru nad procesem szkolenia AI.

Podsumowując, choć syntetyczne dane stanowią ekscytujące i obiecujące narzędzie, ich potencjał jest ograniczony przez bariery technologiczne i etyczne. Wciąż potrzebujemy ludzi w procesie tworzenia i szkolenia sztucznej inteligencji, by zapewnić, że modele są zarówno skuteczne, jak i sprawiedliwe. Przyszłość może przynieść rewolucję w tej dziedzinie, ale tymczasem pozostaje jeszcze wiele do udoskonalenia.