Nowa Era Rozwoju Sztucznej Inteligencji: Co Przynosi Model OpenAI O3?

Ostatni miesiąc przyniósł kolejną rewolucję w świecie sztucznej inteligencji, a wszystko za sprawą nowego modelu OpenAI, o3. Ten model, zaprezentowany jako kolejny krok ku zaawansowanym systemom rozumującym, zdaje się rzucać nowe światło na sposób skalowania AI, budząc jednocześnie podziw i liczne kontrowersje. W miarę jak metody skalowania osiągają kres swoich możliwości, o3 wskazuje na zupełnie inny kierunek działań – tzw. test-time scaling, choć metoda ta nie jest pozbawiona pewnych wyzwań.

Nowe Wzorce Skalowania: Potwierdzenie Progresu

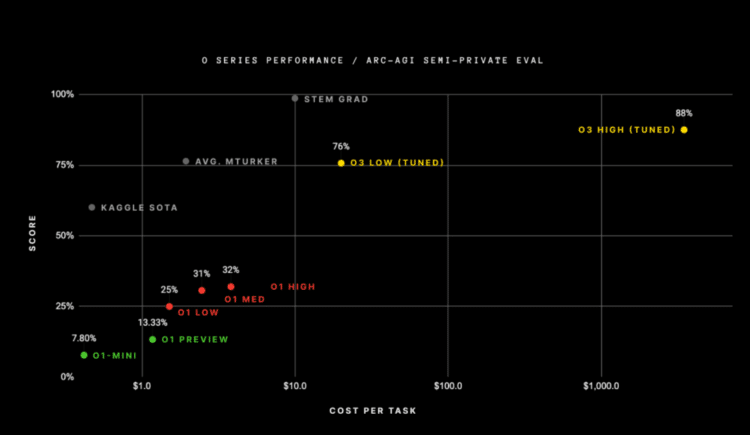

W czasie, kiedy wielu twierdziło, że rozwój modeli AI osiągnął swe granice, o3 zaskoczył świat technologii imponującą wydajnością. Model uzyskał najlepszy wynik w teście ARC-AGI, który mierzy zdolności ogólnej inteligencji, osiągając wynik 88% w jednym z podejść. Co więcej, model poradził sobie z trudnymi testami matematycznymi, wyprzedzając konkurencję, gdzie inne modele zdobywały jedynie kilka procent.

Tym samym o3 przesuwa granicę możliwości, co dla wielu oznacza, że stały rozwój AI jest nadal możliwy, o ile podejdzie się do skalowania w sposób bardziej innowacyjny. Nie brakuje jednak sceptyków, którzy obawiają się kosztów związanych z wdrożeniem tego modelu w praktycznych zastosowaniach. Już teraz wiadomo, że ogromna moc obliczeniowa, wymagana do działania o3, znacząco zwiększa koszty operacyjne.

Co Kryje Się za Test-Time Scaling?

Jednym z kluczowych aspektów modelu o3 jest zastosowanie metody test-time scaling. W tym podejściu do działania modelu wykorzystuje się większe zasoby obliczeniowe w trakcie fazy wnioskowania, czyli momencie, kiedy użytkownik wprowadza zapytanie, a model na nie odpowiada. OpenAI nie ujawnia wszystkich szczegółów technicznych, jednak istnieją przypuszczenia, że proces ten wymaga użycia większej liczby chipów obliczeniowych, silniejszych wersji sprzętu lub dłuższego czasu obliczeń, co czasami trwa nawet 10-15 minut przed wygenerowaniem odpowiedzi.

Choć test-time scaling wydaje się być obiecującym sposobem na zwiększenie wydajności, generuje również nieoczekiwane wyzwania. Jednym z nich są koszty związane z tak długotrwałymi i zasobożernymi obliczeniami. Dla porównania, wysoka wydajność wersji o3 pozwoliła uzyskać niespotykane dotąd wyniki na poziomie ARC-AGI, ale koszt jednej sesji to ponad 1 000 USD. Dla kontrastu, wcześniejszy model o1 kosztował jedynie 5 USD za podobne zadanie.

Czy Koszty Uzyskania Inteligencji Przewyższają Zyski?

Tu pojawia się fundamentalne pytanie: czy korzyści wynikające z zastosowania takich modeli przewyższają ich koszty? François Chollet, twórca benchmarku ARC-AGI, zauważył, że mimo doskonałych wyników modelu o3, wysokie wydatki na jego działanie ograniczają jego praktyczność. Podczas gdy człowiek mógłby rozwiązać podobne zadania za ułamek tych kosztów, model AI wymagał zainwestowania tysięcy dolarów w same zasoby obliczeniowe.

Chollet podkreśla jednak, że o3 jest znakiem przełomu w sztucznej inteligencji – systemem zdolnym do adaptacji i rozwiązywania nowych, wcześniej nieprzewidzianych problemów. Choć nie można jeszcze mówić o osiągnięciu przez AI poziomu ogólnej inteligencji (AGI), to właśnie takie projekty jak o3 mierzą postęp w tym kierunku.

Dla Kogo Modele o3 i Kolejne?

Z perspektywy użytkownika indywidualnego czy biznesowego, modele takie jak o3 raczej nie staną się standardem w codziennym użytku – przynajmniej na razie. Ich wysoki koszt przeznaczenia sprawia, że bardziej dopasowane będą do zastosowań instytucjonalnych, takich jak sektor finansowy, badania naukowe czy zaawansowane prace przemysłowe. Ekspert z Wharton, Ethan Mollick, zauważył, że uniwersytety, centra badawcze czy korporacje przemysłowe mogą uzasadnić tysiące dolarów wydanych na jedno zadanie, o ile uzyskane wyniki będą istotnie wpływać na podejmowane decyzje.

Jednocześnie istnieje potencjał do obniżenia kosztów działania modeli AI poprzez rozwój nowej generacji chipów obliczeniowych, takich jak produkty Groq, Cerebras czy MatX. Przyszłość skalowania AI może leżeć właśnie w tych bardziej efektywnych technologicznie rozwiązaniach.

Ograniczenia i Poszukiwanie Kolejnych Wyzwań

Pomimo ogromnych kosztów, model o3 nie eliminuje kluczowych problemów współczesnej AI, takich jak tendencja do „halucynacji” – generowania błędnych odpowiedzi. Takie niedoskonałości sprawiają, że modele te nadal wymagają ostrożności przy ich stosowaniu. Każda odpowiedź dostarczana przez AI powinna być traktowana z odpowiednią rezerwą, co OpenAI wyraźnie zaznacza w swoich produktach.

Przyszłość skalowania systemów o takich możliwościach jak o3 zdaje się nadal pełna wyzwań. Wobec rosnących wymagań obliczeniowych i kosztów, pytanie brzmi: jakie nowe sposoby opracuje świat technologii, aby utrzymać postęp AI? Choć o3 budzi mieszane reakcje, jedno jest pewne – kierunek wyznaczony przez test-time scaling będzie poważnie rozważany w najbliższych latach.

Podsumowując, model OpenAI o3 to świadectwo dynamicznego rozwoju sztucznej inteligencji i dowód, że wciąż istnieją nowe metody zwiększania wydajności nawet w obliczu ograniczeń skalowania. Zarówno koszty, jak i ograniczona dostępność sugerują, że systemy tego typu pozostaną na razie produktami niszowymi, ale ich wpływ na przyszłość AI – i jej możliwości – jest niezaprzeczalny.