Wraz z rosnącym zainteresowaniem sztuczną inteligencją, coraz więcej programistów i entuzjastów technologii poszukuje szybciej działających i bardziej elastycznych sposobów uruchamiania dużych modeli językowych (LLM) na komputerach lokalnych. Dziś nie trzeba już korzystać z mocy obliczeniowej chmury — narzędzia takie jak LM Studio umożliwiają uruchamianie zaawansowanych modeli AI bezpośrednio na własnym sprzęcie. W połączeniu z kartami graficznymi NVIDIA GeForce RTX, użytkownicy zyskują nie tylko wydajność, ale także pełną kontrolę nad danymi i prywatnością.

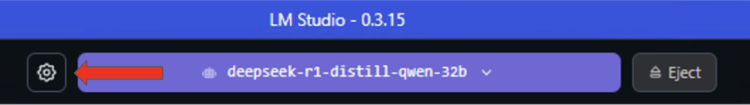

LM Studio to jedno z najpopularniejszych rozwiązań do lokalnego uruchamiania modeli językowych. Aplikacja oparta na wysoko wydajnym środowisku llama.cpp pozwala działać w trybie offline, oferując również możliwość wystawienia interfejsu API kompatybilnego z OpenAI. Dzięki temu użytkownicy mogą integrować sztuczną inteligencję z własnymi systemami, aplikacjami czy przepływami pracy. Najnowsza wersja LM Studio 0.3.15 przynosi istotne usprawnienia, w tym zoptymalizowane działanie z biblioteką CUDA 12.8, co znacząco przyspiesza ładowanie modeli oraz skraca czas odpowiedzi.

Aktualizacja przynosi także funkcje skierowane do deweloperów, takie jak udoskonalona obsługa parametrów „tool_choice”, umożliwiająca precyzyjne zarządzanie wywołaniami narzędzi zewnętrznych przez model, oraz odświeżony edytor promptów systemowych. To rozwiązania, które szczególnie przypadną do gustu tym użytkownikom, którzy wykorzystują LLM w bardziej złożonych środowiskach lub do budowania agentów AI.

Niezależnie od tego, czy chcesz poeksperymentować z AI na potrzeby własne, czy też zintegrować rozwiązania językowe z aplikacjami programistycznymi lub korporacyjnymi, LM Studio oferuje pełną elastyczność. Możesz korzystać z niego jak z klasycznego interfejsu czatu, przeprowadzać sesje Q&A na podstawie lokalnych dokumentów lub wystawić lokalne API z dostępem do modelu. Przykładowo, użytkownicy popularnej aplikacji do zarządzania wiedzą — Obsidian — mogą dzięki dedykowanym wtyczkom, takim jak Text Generator i Smart Connections, korzystać z funkcji tworzenia tekstu, streszczania dokumentów czy zadawania pytań na podstawie własnych notatek — wszystko z wykorzystaniem lokalnego modelu AI, bez konieczności przesyłania danych do chmury.

LM Studio obsługuje szeroki wachlarz modeli open source, takich jak Gemma, Llama 3, Mistral czy Orca, a także różne warianty kwantyzacji — od 4-bitowych modeli po pełną precyzję. Co więcej, dzięki integracji z inferencyjnym backendem llama.cpp, wspieranym przez NVIDIA i silnie zoptymalizowanym pod karty GeForce RTX, lokalna obsługa LLM staje się wyjątkowo szybka i wydajna.

Fundamentem przyspieszenia działania jest otwartoźródłowe środowisko llama.cpp, zoptymalizowane do pracy na konsumenckim sprzęcie. Współpraca inżynierów NVIDIA ze społecznością LM Studio pozwoliła na wprowadzenie wielu usprawnień, takich jak wykorzystanie grafów CUDA, które grupują wiele operacji GPU w jedno wywołanie CPU — zmniejszając tym samym obciążenie procesora i zwiększając przepustowość nawet o 35%. Dodatkowo funkcje takie jak Flash Attention poprawiają sposób, w jaki modele przetwarzają dane, zwiększając szybkość generowania odpowiedzi nawet o 15%, bez dodatkowego zapotrzebowania na pamięć czy moc obliczeniową.

Co ważne, LM Studio jest w pełni kompatybilne ze wszystkimi generacjami kart RTX, od GeForce RTX 20 po najnowsze układy klasy NVIDIA Blackwell. Dzięki temu użytkownicy mogą tworzyć lokalne środowiska AI zarówno na laptopach, jak i potężnych komputerach stacjonarnych.

Aby rozpocząć przygodę z lokalną AI, wystarczy pobrać LM Studio, dostępne dla systemów Windows, macOS i Linux. Po prostym procesie instalacji i konfiguracji, można zacząć korzystać z modeli językowych z niezwykłą wydajnością i prywatnością. Kroki te obejmują zainstalowanie odpowiedniego runtime’u z obsługą CUDA 12, uruchomienie opcji Flash Attention oraz ustawienie modelu na przetwarzanie całkowicie przez GPU, co gwarantuje maksymalną szybkość działania.

Dzięki takim funkcjom jak predefiniowane modele, szeroki wybór formatów kwantyzacji czy programistyczny dostęp do parametrów inference — LM Studio to kompleksowe narzędzie zarówno dla początkujących, jak i profesjonalistów. Kod źródłowy projektu oraz najnowsze aktualizacje są dostępne na GitHubie, co dodatkowo podkreśla jego otwartość i rozwój napędzany przez aktywną społeczność.

W świecie, gdzie rola AI rośnie z dnia na dzień, lokalna infrastruktura na komputerze z kartą NVIDIA RTX i LM Studio stanowi przyszłościowe i niezależne rozwiązanie. To więcej niż tylko eksperymenty — to aktywna transformacja sposobu, w jaki tworzymy, analizujemy dane i komunikujemy się z technologią.