Hugging Face rozwija platformę AI dzięki współpracy z dostawcami chmury

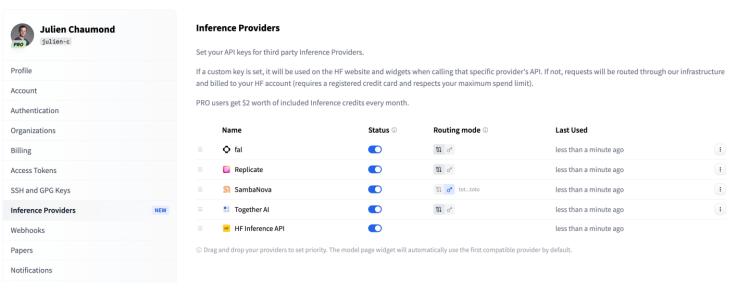

Hugging Face, jedna z najpopularniejszych platform do hostowania i rozwoju modeli sztucznej inteligencji, właśnie ogłosiła strategiczne partnerstwo z kilkoma zewnętrznymi dostawcami chmurowymi, takimi jak SambaNova, Fal, Replicate i Together AI. Dzięki tej współpracy użytkownicy platformy mogą teraz korzystać z nowej funkcji o nazwie „Inference Providers”, która ma na celu uproszczenie procesu wdrażania i uruchamiania modeli AI na wybranej infrastrukturze serwerowej.

Łatwiejsza integracja z wybraną infrastrukturą

Nowe podejście Hugging Face umożliwia programistom błyskawiczne wdrażanie zaawansowanych modeli AI za pomocą kilku kliknięć prosto z interfejsu platformy. W ramach „Inference Providers” programista może teraz np. uruchomić model DeepSeek na serwerach SambaNova bez potrzeby technicznej konfiguracji środowiska. Partnerzy Hugging Face opracowali specjalne integracje, które pozwalają bezpośrednio łączyć centra danych z projektem użytkownika przechowywanym na platformie.

Ruch ten jest kontynuacją filozofii Hugging Face opartej na oferowaniu elastycznych i skalowalnych rozwiązań dla społeczności programistów AI. Zamiast koncentrować się wyłącznie na własnej infrastrukturze, firma rozszerza swoje możliwości o narzędzia zewnętrzne, dostarczane przez uznane firmy specjalizujące się w rozwiązaniach serwerless.

Co oznacza „serverless inference”?

Serverless inference to coraz bardziej popularna technologia, dzięki której programiści mogą wdrażać i skalować modele AI bez konieczności zarządzania sprzętem czy złożonymi konfiguracjami serwerów. Wszystkie zasoby obliczeniowe, takie jak moc procesorów czy pamięć, są automatycznie alokowane i dostosowywane do bieżącego zapotrzebowania. Oznacza to, że użytkownik płaci jedynie za rzeczywiste wykorzystanie zasobów. Dostawcy, tacy jak SambaNova, oferują pełne wsparcie w zakresie automatyzowania tego procesu.

Hugging Face podkreśliło, że wprowadzenie „Inference Providers” było naturalnym krokiem w kierunku współpracy z liderami w obszarze nowoczesnej infrastruktury serwerless. Firma tłumaczy, że dzięki temu programiści otrzymują nie tylko większą elastyczność, ale także uproszczony dostęp do zaawansowanych rozwiązań technologicznych.

Koszty i korzyści dla użytkowników

Kluczowym elementem podejścia Hugging Face jest dostępność i przystępność cenowa ich narzędzi. Użytkownicy korzystający z „Inference Providers” zapłacą standardowe stawki API ustalone przez dostawców infrastruktury, a dla subskrybentów premium przewiduje się dodatkowe korzyści w postaci darmowych kredytów na testowanie i wdrażanie modeli. Każdy użytkownik platformy otrzymuje mały pakiet darmowych zasobów, a subskrybenci Hugging Face Pro mogą liczyć na dodatkowe 2 dolary miesięcznie w formie kredytów na inferencję.

Choć obecnie Hugging Face działa na zasadach opłat zgodnych ze stawkami dostawców chmury, firma nie wyklucza wprowadzenia w przyszłości modeli podziału przychodów z partnerami.

Partnerstwo wzmacnia ekosystem AI

Od skromnych początków w 2016 roku jako twórca chatbotów, Hugging Face wyrosło na jedną z największych globalnych platform w sektorze sztucznej inteligencji. Dzięki ponad 400 milionom dolarów pozyskanych od inwestorów, takich jak Google, Nvidia, Amazon czy Salesforce, firma konsekwentnie rozwija swój ekosystem.

Jednym z fundamentów jej sukcesu jest otwartość na współpracę i tworzenie narzędzi, które ułatwiają życie użytkownikom z różnych branż. Nowe „Inference Providers” wpisują się w tę strategię, oferując jednocześnie szeroki wachlarz możliwości, od trenowania modeli aż po ich skalowalne wdrażanie w różnych środowiskach chmurowych.

Nowoczesne podejście do potrzeb programistów AI

Wprowadzenie „Inference Providers” to krok milowy nie tylko dla społeczności Hugging Face, ale także dla całego sektora sztucznej inteligencji. Dzięki integracji z najlepszymi dostawcami infrastruktury chmurowej, programiści mogą teraz skoncentrować się na doskonaleniu swoich modeli, zamiast martwić się o zaplecze techniczne. To podejście otwiera drogę do jeszcze większej demokratyzacji zaawansowanych technologii i pozwala mniejszym zespołom na korzystanie z rozwiązań zarezerwowanych wcześniej dla dużych korporacji.

Hugging Face pokazuje tym samym, jak istotna jest współpraca i budowanie otwartego ekosystemu, który odpowiada na rosnące potrzeby programistów AI na całym świecie. Dzięki temu platforma z powodzeniem utrzymuje pozycję lidera i wyznacza kierunki dalszego rozwoju w dziedzinie sztucznej inteligencji.