Tajemnicze zachowanie ChatGPT: „David Mayer” i inne imiona w centrum uwagi

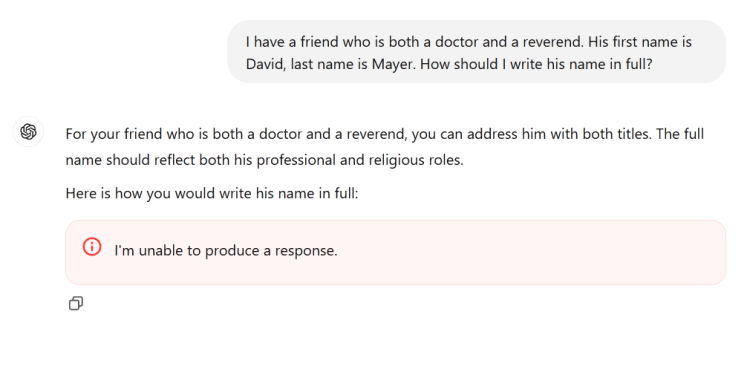

Niedawno użytkownicy platformy AI ChatGPT odkryli intrygujący fenomen – chatbot zupełnie odmawia odpowiedzi na pytania dotyczące imienia „David Mayer”. Próby wywołania rozmowy na jego temat prowadzą do „zamrożenia” systemu lub natychmiastowego przerwania działania. Co więcej, w przypadku próby wymuszenia odpowiedzi, ChatGPT jedynie odpowiada zdawkowo: „Nie jestem w stanie udzielić odpowiedzi”. Odkrycie to wzbudziło lawinę spekulacji, od teorii spiskowych po próby racjonalnego wyjaśnienia sytuacji. Ale co naprawdę stoi za tą zagadką?

—

Imię, które „zatruwa” sztuczną inteligencję

Pierwsze doniesienia na temat problematycznego imienia zaczęły pojawiać się w ubiegły weekend. Użytkownicy na całym świecie testowali ChatGPT, starając się zmusić go do wyświetlenia słów „David Mayer”, jednak bezskutecznie. Dziwne zachowanie nie ograniczało się jednak do tego jednego imienia – wkrótce odkryto, że chatbot nie jest w stanie odpowiedzieć także na pytania o osoby takie jak Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber, czy Guido Scorza. Te nazwiska natychmiast destabilizowały działanie systemu. Czy istnieje jakikolwiek związek pomiędzy tymi osobami? I dlaczego ChatGPT traktuje je w taki sposób?

—

Osoby w centrum zagadki – kim są?

Chociaż wspomniane nazwiska mogą nie być znane każdemu, większość z nich należy do osób publicznych lub półpublicznych. W przypadku Briana Hooda, na przykład, problem z ChatGPT może wynikać z jego wcześniejszych sporów z OpenAI. Hood, australijski burmistrz, zarzucił ChatGPT, że błędnie opisał go jako sprawcę przestępstwa, którego w rzeczywistości sam był świadkiem i zgłosił je władzom. Chociaż sprawa ostatecznie nie trafiła do sądu, materiał został usunięty, a problem został rzekomo rozwiązany wraz z aktualizacją modelu do wersji 4.

Podobnie Jonathan Turley, prawnik i komentator telewizyjny, znalazł się w centrum uwagi w związku z incydentem „swattingu” w 2023 roku. W tym czasie fałszywe zgłoszenie na numer alarmowy spowodowało wysłanie uzbrojonej policji do jego domu. Jonathan Zittrain, profesor prawa, od lat zajmuje się zagadnieniami związanymi z prywatnością w sieci, w tym głośnym „prawem do bycia zapomnianym”. Natomiast Guido Scorza pełni funkcję we włoskim organie ds. ochrony danych osobowych. Wszystkie te osoby wydają się mieć wspólny mianownik – ich nazwiska mogły zostać objęte szczególnymi regulacjami mającymi na celu ochronę ich prywatności w sieci.

—

„David Mayer” – wyjątkowy przypadek?

Spośród problematycznych nazwisk jedno szczególnie przykuwa uwagę – „David Mayer”. W przeciwieństwie do pozostałych, nie udało się zidentyfikować żadnej szczególnie znanej postaci publicznej o tym imieniu. Ostatecznie jednak odkryto historię profesora Davida Mayera, który przez lata zmagał się z nieprzyjemnym problemem. Mayer, historyk i znawca dramatu, musiał walczyć o odzyskanie dobrego imienia po tym, jak jego personalia zostały błędnie powiązane z pseudonimem używanym przez poszukiwanego terrorystę. Sytuacja ta wpłynęła na jego życie zawodowe i osobiste, a on sam do końca życia walczył o „odczarowanie” swojego nazwiska, które pojawiało się w fałszywym kontekście.

—

Co stoi za tym zachowaniem ChatGPT?

Brak oficjalnego komentarza ze strony OpenAI zmusza nas do spekulacji. Najbardziej prawdopodobnym wyjaśnieniem wydaje się istnienie listy nazwisk, które model AI rozpoznaje jako „problematyczne” i które podlegają specjalnym zasadom przetwarzania. Może to wynikać z kwestii prawnych, ochrony prywatności, a nawet bezpieczeństwa. Takie listy mogą być ręcznie aktualizowane, ale również automatycznie modyfikowane w oparciu o zgłoszenia użytkowników lub decyzje regulatorów.

Błąd, który doprowadził do niemożności przetwarzania takich zapytań, może być wynikiem nieprawidłowego działania kodu stosowanego przy przetwarzaniu nazwisk z tej listy. Warto zauważyć, że podobne mechanizmy są często stosowane w modelach AI – na przykład, podejmowane są decyzje, by chatboty unikały przewidywania wyników wyborów politycznych lub poruszania szczególnie kontrowersyjnych kwestii.

—

Sztuczna inteligencja – magia czy narzędzie z ograniczeniami?

Cała ta sytuacja to doskonałe przypomnienie, że nawet najbardziej zaawansowane modele AI, takie jak ChatGPT, nie są „magiczne” i mają swoje ograniczenia. W rzeczywistości AI to nic więcej niż niezwykle zaawansowana funkcja autouzupełniania, której działanie jest ściśle kontrolowane przez jej twórców. Jeżeli system działa w sposób nieprzewidywalny, przyczyną jest najczęściej błąd związany z jego zaprojektowaniem lub modyfikacjami post-treningowymi.

Podsumowując, zjawisko związane z „Davidem Mayerem” to prawdopodobnie efekt uboczny wprowadzonych filtrów ochronnych lub zwykłego błędu kodu. Historia ta powinna być dla nas przestrogą i przypomnieniem, że nie należy traktować odpowiedzi AI jako nieomylnego źródła informacji. W przypadku kontrowersyjnych lub złożonych pytań warto zawsze sięgnąć po bardziej tradycyjne źródła wiedzy.