Rozwój generatywnej sztucznej inteligencji na podstawie RAG (Retrieval-Augmented Generation)

Generatywna sztuczna inteligencja to jedna z najnowszych i najbardziej obiecujących technologii, która stopniowo zyskuje coraz większe zaufanie użytkowników. Technologia ta pozwala na tworzenie zaawansowanych modeli językowych, takich jak duże modele językowe (LLM), posiadające zdolność do rozumienia i przetwarzania naturalnego języka w sposób zbliżony do człowieka. Jednym z przełomowych rozwiązań związanych z tymi modelami jest technika Retrieval-Augmented Generation (RAG), umożliwiająca dostęp do zewnętrznych, precyzyjnych źródeł wiedzy w celu zwiększenia wiarygodności oraz trafności wyników generowanych przez SI.

Jak działa RAG?

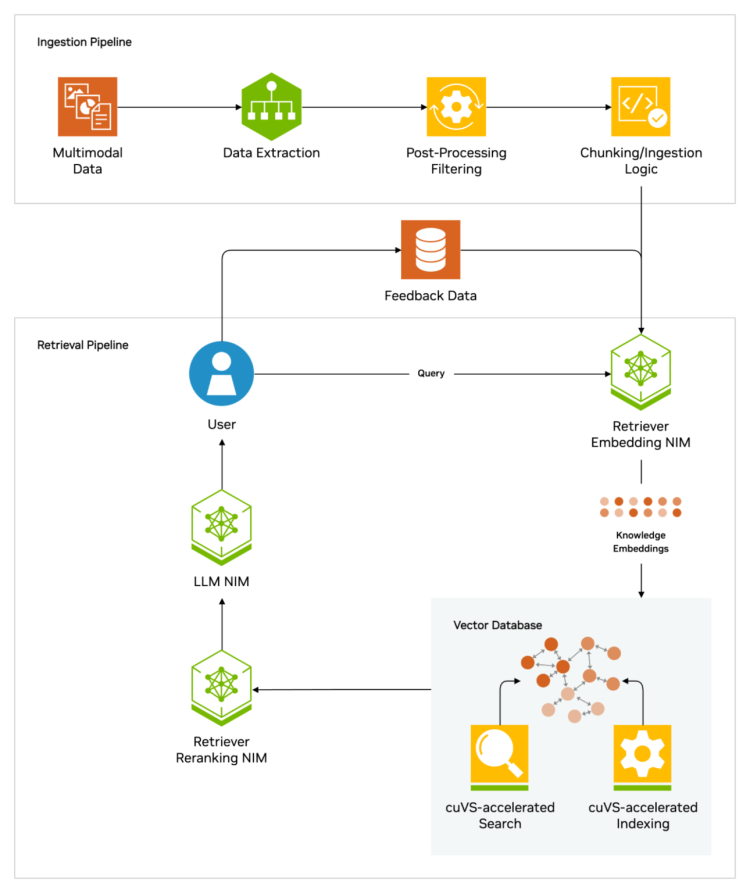

Podstawa działania Retrieval-Augmented Generation polega na połączeniu mocy generatywnego modelu językowego z informacjami pobieranymi w czasie rzeczywistym z odpowiednich baz wiedzy. Modele LLM tradycyjnie są trenowane na ogromnych zbiorach danych, co pozwala im rozpoznawać wzorce językowe i precyzyjnie reagować na różne zapytania. Jednak ich zasoby wiedzy są statyczne — zawarte w „parametrach” modelu na etapie wstępnego treningu. Kiedy zapytanie dotyczy bardziej aktualnych lub niszowych informacji, modele bazujące wyłącznie na takim podejściu często nie są w stanie zapewnić odpowiedzi o wysokiej precyzji.

Technologia RAG działa jak swoisty pomocnik prawnika szukający precedensów. Gdy użytkownik wprowadza zapytanie, model SI najpierw generuje jego wektorowy odpowiednik — formę numeryczną, czytelną dla komputera. Następnie, ten wektor jest zestawiany z bazą danych, w której przechowywane są podobnie zakodowane fragmenty wiedzy. Zapisane w bazie podobieństwa są odczytywane, a powiązane informacje są przekazywane z powrotem do LLM, który na ich podstawie formułuje odpowiedź. Co istotne, technologia ta umożliwia dodawanie cytowanych źródeł, co znacznie zwiększa wiarygodność i możliwość weryfikacji wyników.

Zalety technologii Retrieval-Augmented Generation

Jednym z największych wyzwań generatywnej AI jest problem tzw. halucynacji, czyli sytuacji, w której model formułuje odpowiedzi, które brzmią logicznie, lecz są błędne lub niedokładne. RAG pomaga ograniczyć ten problem, umożliwiając modelom dostęp do aktualnych źródeł danych. Dodatkowo, dzięki podkreśleniu przejrzystości i dodawaniu odnośników, technologia ta buduje większe zaufanie użytkowników do systemów opartych na AI.

Technika ta sprawdza się również w oszczędności czasu i zasobów. W przeciwieństwie do kosztownego i czasochłonnego trenowania modeli z nowymi zbiorami danych, RAG pozwala na „gorące podmiany” źródeł wiedzy — natychmiastowe zaktualizowanie danych dostępnych dla modelu LLM. Wprowadzenie tej technologii w oprogramowaniu wymaga tylko kilku linii kodu, co dodatkowo ułatwia jej implementację deweloperom.

Przykłady zastosowań RAG

Zastosowania RAG są niemal nieograniczone, od biznesowych asystentów po zaawansowane systemy medyczne. Na przykład w medycynie modele LLM współpracujące z indeksami wiedzy medycznej mogą pomóc lekarzom w diagnozowaniu chorób oraz szybkim dostępie do najnowszych wyników badań. W finansach natomiast mogą wspierać analityków w precyzyjnej interpretacji trendów rynkowych i danych giełdowych.

Inne przykłady obejmują szkolenia dla pracowników, lepszą obsługę klienta w sektorze usługowym, a także zwiększenie produktywności programistów poprzez generowanie kodu lub sporządzanie dokumentacji technicznej na podstawie rozbudowanych baz danych firmowych.

Technologia ta jest już wykorzystywana przez takie globalne firmy jak Google, IBM, Microsoft, NVIDIA czy Amazon Web Services (AWS). Każda z tych organizacji opracowuje rozwiązania wspierające przedsiębiorstwa w przetwarzaniu danych oraz automatyzacji procesów z wykorzystaniem własnych wersji RAG.

Dalsze perspektywy rozwoju

Wprowadzenie technologii RAG wynika z długotrwałego rozwoju systemów przetwarzania języka naturalnego (NLP). Pierwszym krokiem w tę stronę były wczesne próby stworzenia systemów pytania i odpowiedzi w latach 70. XX wieku. Na przestrzeni dekad narzędzia takie jak IBM Watson czy usługa „Ask Jeeves” spopularyzowały ideę wyszukiwania informacji w zrozumiały sposób. Obecne wykorzystanie LLM w połączeniu z zasobami zewnętrznymi w modelu RAG to kolejny krok ku bardziej zaawansowanym asystentom AI.

Dzięki implementacji takiej technologii przedsiębiorstwa mogą zwiększać efektywność, zaufanie klientów i dostarczać bardziej spersonalizowane doświadczenia użytkownikom końcowym. Co więcej, takie narzędzia stają się szerzej dostępne — nawet na poziomie lokalnym, na komputerach osobistych z GPU NVIDIA RTX, umożliwiając użytkownikom łączenie modeli AI z ich prywatnymi, lokalnymi bazami danych.

Podsumowanie

Retrieval-Augmented Generation to istotny krok w rozwoju generatywnej AI, umożliwiający osiąganie bardziej precyzyjnych i wiarygodnych wyników. Dzięki połączeniu mocy LLM z aktualnymi bazami wiedzy możemy liczyć na nowe sposoby wykorzystania tej technologii — od medycyny po wsparcie decyzji biznesowych. RAG stanowi fundament dalszego rozwoju agentów autonomicznych i zaawansowanych systemów pytania i odpowiedzi, które kształtują przyszłość sztucznej inteligencji.