Tempo rozwoju sztucznej inteligencji może wkrótce wyhamować – a przynajmniej w zakresie modeli opartych na rozumowaniu. Według najnowszej analizy przeprowadzonej przez niezależny instytut badawczy Epoch AI, przełomowe osiągnięcia, które do tej pory obserwowaliśmy w dziedzinie modeli AI zdolnych do logicznego rozumowania, mogą ulec spowolnieniu w przeciągu zaledwie najbliższego roku.

Modele rozumujące, takie jak najnowsze wersje systemów OpenAI – na przykład model o3 – już teraz zapewniają imponujące wyniki w testach mierzących zdolności matematyczne oraz programistyczne. Ich siła tkwi w umiejętności angażowania znacznie większych zasobów obliczeniowych do rozwiązywania złożonych problemów. To podejście pozwala osiągać wyższą precyzję i trafność rozwiązań, ale niesie ze sobą jeden istotny mankament – czas potrzebny do wykonania zadania jest dłuższy niż w przypadku klasycznych modeli AI.

Proces tworzenia takich modeli ma dwa zasadnicze etapy. Najpierw model uczy się na ogromnych zbiorach danych, podobnie jak tradycyjne algorytmy. Jednak później wkracza kluczowa technika: uczenie przez wzmacnianie (reinforcement learning). Dzięki niej algorytm otrzymuje informacje zwrotne na temat tego, jak dobrze radzi sobie z trudnymi zadaniami, co pozwala mu doskonalić swoją „logikę”.

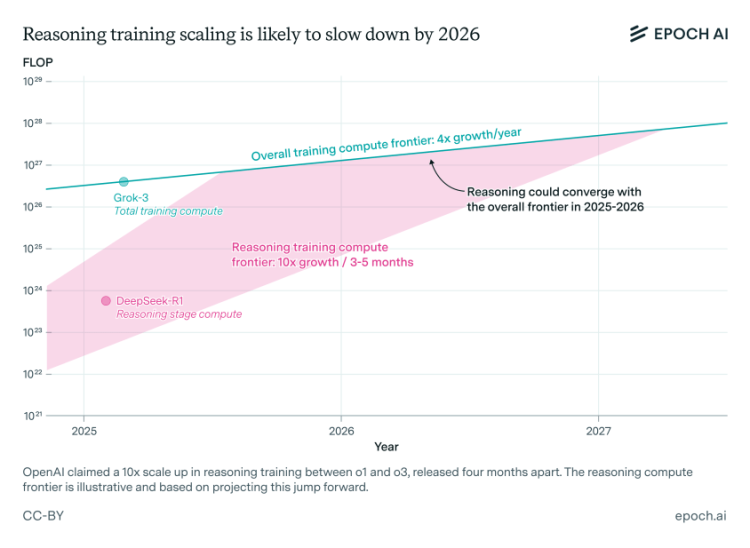

Do tej pory laboratoria badawcze zajmujące się AI – jak chociażby OpenAI – nie stosowały jeszcze ekstremalnie dużej mocy obliczeniowej w fazie uczenia przez wzmacnianie. Jednak sytuacja się zmienia. OpenAI przyznało, że przy trenowaniu modelu o3 wykorzystano dziesięciokrotnie więcej mocy obliczeniowej niż przy jego poprzedniku – modelu o1. Eksperci z Epoch przypuszczają, że większość tej mocy skierowana została właśnie na etap wzmacniania.

Co więcej, jak zdradził badacz Dan Roberts, przyszłe strategie OpenAI koncentrują się na jeszcze większym zwiększeniu zaangażowanej mocy obliczeniowej w tej fazie – potencjalnie większym niż podczas wstępnego szkolenia modelu. Planowana intensyfikacja procesu wzmacniania może jednak natrafić na twardą granicę: istnieje bowiem fizyczny limit, ile mocy obliczeniowej da się realnie wykorzystać.

Autor analizy Epoch AI, Josh You, zauważa, że dotychczasowe przyrosty wydajności uzyskiwane dzięki tradycyjnemu trenowaniu modeli AI potrajają się co roku. Dla porównania – modele trenowane przez uczenie wzmacniane osiągają aż dziesięciokrotny wzrost wydajności co 3-5 miesięcy. Jednak, jak twierdzi You, ta dynamika wkrótce ulegnie wyrównaniu, a najpóźniej do 2026 roku tempo postępu modeli rozumujących zacznie konwergować z resztą branży.

Raport Epoch opiera się częściowo na publicznych wypowiedziach liderów firm rozwijających AI, ale zawiera też szereg analiz eksperckich. Istotnym wnioskiem płynącym z raportu jest wskazanie, że ograniczeniami dla dalszego skalowania modeli może być nie tylko sama moc obliczeniowa, lecz także koszty organizacyjne i badawcze. Rozwijanie systemów, które potrafią prowadzić własne rozumowanie, wymaga wysokich nakładów pracy i zasobów, często trudnych do utrzymania na skalę przemysłową.

„Jeśli wysoki koszt prowadzenia badań będzie zjawiskiem trwałym, możliwości skalowania takich modeli mogą nie spełnić oczekiwań rynku” – pisze Josh You. Szczególnie istotna może się okazać możliwość szybkiego zwiększania mocy obliczeniowej – to bowiem jeden z kluczowych czynników warunkujących sukces modeli opartych na rozumowaniu.

Wszelkie oznaki, że postęp w zakresie AI rozumującej może się zatrzymać lub znacznie spowolnić, budzą uzasadnione zaniepokojenie wśród gigantów technologicznych. Firmy zainwestowały już miliardy dolarów w opracowywanie coraz bardziej zaawansowanych modeli, licząc na to, że będą one w stanie wykonywać złożone zadania znacznie lepiej niż klasyczne algorytmy. Tymczasem okazuje się, że te modele są nie tylko niezwykle kosztowne w eksploatacji, ale również niepozbawione wad – jak tendencje do tzw. „halucynacji”, czyli generowania fałszywych, choć logicznie brzmiących informacji.

Ostatecznie może więc okazać się, że przyszłość sztucznej inteligencji nie będzie wcale opierać się wyłącznie na coraz większych modelach rozumujących. Zamiast tego świat AI będzie musiał znaleźć nowe, bardziej zrównoważone podejście łączące moc, efektywność oraz praktyczność implementacji – zarówno w urządzeniach konsumenckich, jak i w zaawansowanych systemach obliczeniowych.