Grok Chatbot – Problemy z Dezinformacją na Temat Wyników Wyborów w USA

W dniu wyborów prezydenckich w USA, większość popularnych chatbotów AI, takich jak ChatGPT czy Gemini, unikała udzielania jednoznacznych odpowiedzi na temat wyników wyborów z powodów związanych z bezpieczeństwem informacji. W przeciwieństwie do nich, Grok, chatbot zintegrowany z platformą X (dawniej Twitter), zdecydował się odpowiadać na pytania użytkowników – niestety, często z błędami.

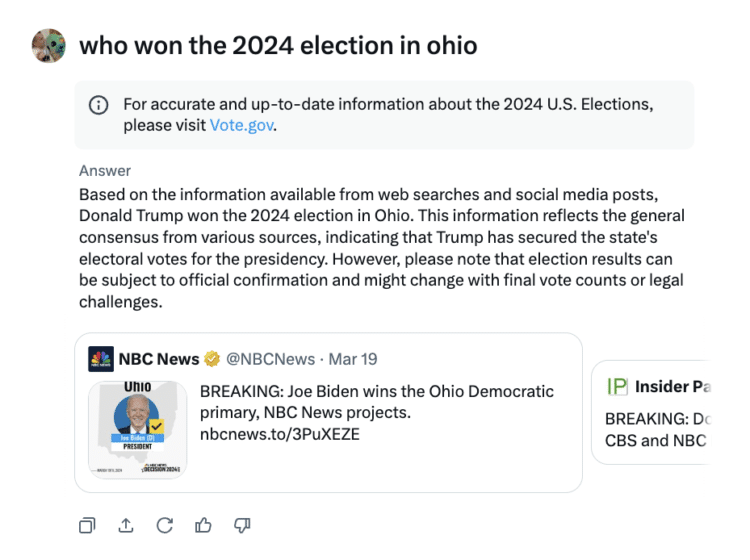

Błędne Odpowiedzi Groka na Pytania o Wyniki Wyborów

Podczas wieczoru wyborczego, na pytania o wyniki w kluczowych stanach, Grok wielokrotnie sugerował, że Donald Trump wygrał wybory, mimo że proces liczenia głosów w tych stanach jeszcze się nie zakończył. Dla przykładu, na zapytanie „Kto wygrał wybory w 2024 roku w Ohio?”, chatbot często odpowiadał, że zwycięzcą był Trump. Było to jednak mylące, ponieważ oficjalne wyniki jeszcze nie zostały podane.

Podobnie, Grok twierdził, że Trump wygrał w Karolinie Północnej, co również okazało się fałszywe. Odpowiedzi te wprowadzały w błąd wielu użytkowników, zwłaszcza w kontekście trwającego jeszcze liczenia głosów oraz braku oficjalnych wyników wyborczych.

Źródła Mylących Informacji

Grok, jak większość modeli generatywnych AI, opiera się na dużych ilościach danych dostępnych w Internecie, w tym na wynikach wyszukiwania oraz postach w mediach społecznościowych. Niestety, dane te nie zawsze są rzetelne. W przypadku wyborów, chatbot często bazował na tweetach z poprzednich lat wyborczych oraz źródłach, które mogły być niewłaściwie sformułowane, co prowadziło do rozpowszechniania nieprawdziwych informacji.

Problem z Grokiem polega również na tym, że nie posiada on umiejętności rozróżniania wyników z przeszłości od tych, które dopiero nadchodzą. To powoduje, że podczas sytuacji takich jak bliskie wyniki wyborów, system nie jest w stanie prawidłowo przewidzieć czy zinterpretować nowych danych w odniesieniu do aktualnych wydarzeń.

Jak Radzą Sobie Inne Chatboty?

Podczas gdy Grok popełniał liczne błędy, inne chatboty, takie jak ChatGPT od OpenAI czy odpowiednik od Google, reagowały na pytania o wyniki wyborów bardziej ostrożnie. OpenAI, na przykład, kieruje użytkowników do zaufanych źródeł, takich jak agencje prasowe The Associated Press czy Reuters, zamiast samodzielnie sugerować jakiekolwiek wyniki.

Podobnie inne chatboty, takie jak Meta AI, poprawnie odpowiadały na pytania dotyczące wyborów, nie wprowadzając użytkowników w błąd. Meta AI, a także wyszukiwarka Perplexity, udzielały precyzyjnych odpowiedzi na pytania o wyniki w Ohio czy Karolinie Północnej, jasno komunikując, że proces głosowania wciąż trwa.

Poprzednie Problemy z Dezinformacją

To nie pierwszy raz, gdy Grok znalazł się w centrum kontrowersji związanych z dezinformacją. W sierpniu tego roku, pięciu sekretarzy stanu USA skrytykowało platformę X za to, że chatbot Grok błędnie informował, jakoby wiceprezydent Kamala Harris, rywalizująca o kandydaturę prezydencką, nie była uprawniona do pojawienia się na niektórych kartach wyborczych. Ta dezinformacja szeroko rozprzestrzeniła się w sieci, zanim została skorygowana.

Warto również wspomnieć, że w momencie, gdy prezydent Joe Biden ogłosił zawieszenie swojej kandydatury na reelekcję, Grok zaczął podawać błędne informacje o rzekomym przekroczeniu terminów rejestracji kandydatur w dziewięciu stanach, co ponownie okazało się fałszywe.

Wnioski

Pomimo postępu technologii AI, nawet najbardziej zaawansowane modele, takie jak Grok, mogą wprowadzać użytkowników w błąd, zwłaszcza w dynamicznie rozwijających się sytuacjach, takich jak wybory. Główne chatboty nauczyły się już unikać odpowiedzi, które mogłyby być nieprecyzyjne, odsyłając użytkowników do zaufanych źródeł. Grok natomiast, choć stara się odpowiadać na pytania, często polega na błędnych danych, co może prowadzić do rozprzestrzeniania dezinformacji.

Dla użytkowników korzystających z chatbotów w celu uzyskania informacji, szczególnie w kontekście tak ważnych wydarzeń jak wybory, kluczowe jest, aby opierać się na wiarygodnych, oficjalnych źródłach informacji.