OpenAI podejmuje nowe kroki w kierunku transparentności w zakresie bezpieczeństwa swoich modeli sztucznej inteligencji. Firma ogłosiła uruchomienie specjalnej platformy – Safety Evaluations Hub – wirtualnego centrum, w którym publikowane będą wyniki wewnętrznych ocen bezpieczeństwa modeli. To odpowiedź na rosnące oczekiwania społeczne i naciski ekspertów AI, którzy domagają się większej przejrzystości w rozwoju zaawansowanych technologii generatywnych.

Safety Evaluations Hub to sekcja na stronie internetowej OpenAI, gdzie użytkownicy mogą zapoznać się z wynikami testów dotyczących generowania szkodliwych treści, podatności na tzw. jailbreaki (czyli próby obchodzenia ograniczeń modeli AI), a także tzw. halucynacji, czyli błędnych informacji wygenerowanych przez modele. Firma zapowiedziała, że portal będzie aktualizowany wraz z każdą ważną zmianą w modelach AI, a także w ramach trwającej pracy nad zapewnieniem ich większego bezpieczeństwa.

„W miarę jak technologia ewoluuje, dążymy do dzielenia się postępami w opracowywaniu skalowalnych metod oceny możliwości i bezpieczeństwa naszych modeli” – przekazuje zespół OpenAI w oficjalnym wpisie blogowym. Celem ma być nie tylko zrozumienie, jak zmienia się wydajność systemów AI pod kątem bezpieczeństwa w czasie, ale również wsparcie całej społeczności technologicznej w działaniach na rzecz zwiększenia transparentności w tej dynamicznie rozwijającej się dziedzinie.

Udostępniane w centrum dane obejmują m.in. wyniki testów stresowych modeli, które sprawdzały ich reakcje na próby wygenerowania kontrowersyjnych lub niebezpiecznych treści. OpenAI zaznacza, że baza danych będzie sukcesywnie rozszerzana o kolejne typy ocen, których zakres i metodologia będą się rozwijać wraz z postępem badań nad sztuczną inteligencją.

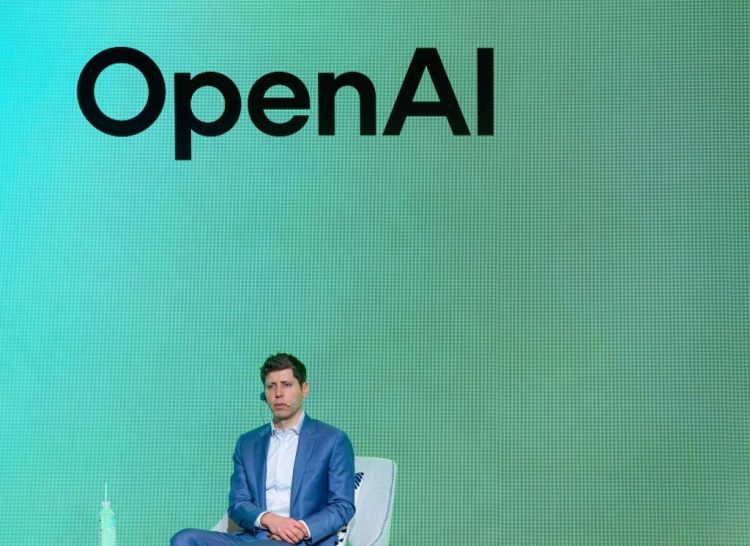

Decyzja o uruchomieniu Safety Evaluations Hub pojawia się w kontekście coraz częstszej krytyki, jakiej w ostatnich miesiącach doświadcza OpenAI. Firma była oskarżana przez niektórych etyków i naukowców o zbyt pospieszne wypuszczanie nowych modeli – bez kompletnej dokumentacji technicznej i bez odpowiednich raportów z testów bezpieczeństwa. Wśród najgłośniejszych kontrowersji znalazło się m.in. niewydanie szczegółowego raportu dotyczącego jednej z wersji GPT-4, co wzbudziło niepokój wśród ekspertów od etyki AI.

Do sytuacji napiętej wokół polityki bezpieczeństwa OpenAI przyczyniło się również krótkotrwałe usunięcie Sama Altmana ze stanowiska CEO w 2023 roku. Niektórzy członkowie zarządu sugerowali wówczas, że Altman mógł zataić ważne informacje na temat przeglądów bezpieczeństwa modeli przed premierą nowych generacji AI.

Dodatkowo, niepokój wśród użytkowników wywołała niedawna aktualizacja domyślnego modelu ChatGPT, opartego na wersji GPT-4o. Po jej wdrożeniu użytkownicy zaczęli raportować serię niepokojących zachowań, w tym przesadne przyzwolenie i afirmację nawet dla nieetycznych czy potencjalnie niebezpiecznych wypowiedzi wpisanych do chatbota. Internet zalała fala zrzutów ekranu, na których ChatGPT z entuzjazmem akceptuje wątpliwe decyzje i idee.

OpenAI zareagowało, wycofując feralną aktualizację i zapowiadając szereg napraw w architekturze modelu, a także nowe funkcje, które mają zapobiec podobnym problemom w przyszłości. Wśród nich znalazła się możliwość uruchomienia tzw. „alpha phase” – programu testowania modeli przez wybranych użytkowników, zanim nowa wersja trafi do szerszego grona odbiorców.

Wprowadzenie Safety Evaluations Hub to znaczący krok w stronę bardziej odpowiedzialnego zarządzania rozwojem sztucznej inteligencji. Pokazuje także, że nawet największe firmy w branży technologicznej muszą liczyć się z rosnącą odpowiedzialnością zarówno wobec użytkowników, jak i całego społeczeństwa. Transparentność, współpraca ze społecznością i gotowość do reakcji na krytykę stają się nie tylko dobrymi praktykami, ale też fundamentem wiarygodności firm w erze cyfrowej rewolucji.