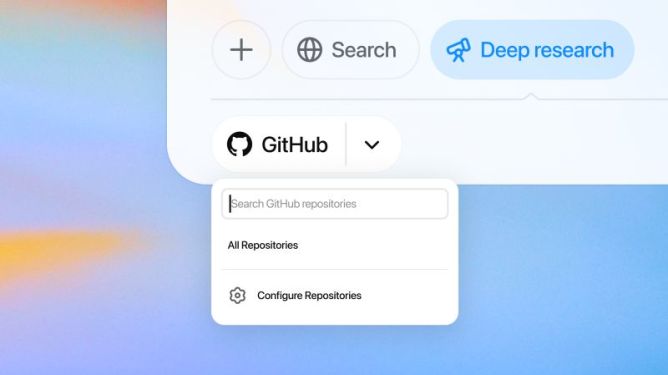

OpenAI rozwija możliwości swojego narzędzia do zaawansowanych badań opartych na sztucznej inteligencji, wprowadzając nową integrację z platformą GitHub. Nowa funkcja, obecnie dostępna w wersji beta, umożliwia użytkownikom usługi ChatGPT Deep Research analizę baz kodu, dokumentacji technicznej oraz zadawanie pytań związanych z konkretnymi projektami programistycznymi. To istotny krok w kierunku jeszcze głębszego powiązania AI z praktyczną pracą zespołów programistycznych.

Nowe połączenie ChatGPT z GitHubem ma przede wszystkim ułatwić twórcom oprogramowania zarządzanie złożonymi projektami. Dzięki niemu użytkownicy mogą rozkładać na czynniki pierwsze specyfikacje produktów, przekształcać je w techniczne zadania i zależności, analizować strukturę kodu i wzorce programistyczne, a także eksplorować sposób implementacji nowych API z wykorzystaniem rzeczywistych przykładów. Integracja stanowi potężne narzędzie wspierające zarówno pojedynczych deweloperów, jak i zespoły inżynieryjne.

Z funkcji tej skorzystać mogą użytkownicy pakietów ChatGPT Plus, Pro i Team, a wkrótce także osoby korzystające z wersji Enterprise oraz edukacyjnej. Choć technologia wciąż znajduje się w fazie testów, jej funkcjonalność już teraz robi wrażenie. OpenAI jasno komunikuje, że nowy „konektor”, jak nazywany jest ten moduł rozszerzający możliwości ChatGPT, to odpowiedź na liczne prośby użytkowników, którzy chcieliby łączyć możliwości generatywnej AI nie tylko z otwartym internetem, ale również z wewnętrznymi repozytoriami firmowymi.

Warto zaznaczyć, że integracja z GitHubem działa w oparciu o uprawnienia dostępu użytkowników. Oznacza to, że ChatGPT będzie mógł analizować wyłącznie te fragmenty kodu, do których konto użytkownika już miało dostęp lub które zostały explicite udostępnione. To istotne dla bezpieczeństwa i prywatności, szczególnie w przypadku projektów komercyjnych i zamkniętych systemów.

Chociaż możliwości ChatGPT imponują, OpenAI nie ukrywa, że narzędzie może czasami popełniać błędy, tzw. halucynacje AI, czyli tworzenie nieprawdziwych lub niepoprawnych informacji. Firma podkreśla jednak, że jego celem jest wsparcie ekspertów, nie zaś ich zastępowanie. Nowa funkcjonalność ma przede wszystkim zaoszczędzić czas i uporządkować procesy analityczne w pracy z kodem.

Wraz z rozszerzeniem integracji z GitHubem firma OpenAI kontynuuje inwestycje w narzędzia wspierające programistów. Niedawno zaprezentowała Codex CLI – otwartoźródłowe narzędzie terminalowe wspomagające kodowanie – oraz zaktualizowała aplikację desktopową ChatGPT, umożliwiając jej analizę kodu w popularnych programach deweloperskich. Co więcej, pojawiły się informacje o planowanym przejęciu startupu Windsurf, który tworzy asystenta programowania opartego na AI. Transakcja ma opiewać na 3 miliardy dolarów, co świadczy o strategicznym znaczeniu sektora programistycznego dla dalszego rozwoju OpenAI.

Równolegle z ogłoszeniem konektora GitHub, firma zaprezentowała nowe opcje dostrajania swoich modeli językowych. Deweloperzy mogą teraz personalizować model o4-mini, który specjalizuje się w rozumowaniu kontekstowym, za pomocą techniki nazwaną reinforcement fine-tuning – doskonalenia opartego na ukierunkowanej ocenie wyników. Podobna możliwość pojawiła się także dla modelu GPT-4.1 nano. O ile o4-mini dostępny jest wyłącznie dla zweryfikowanych organizacji, o tyle wszyscy płacący użytkownicy API mają dostęp do personalizacji GPT-4.1 nano.

W związku z rosnącym ryzykiem nadużyć, OpenAI stopniowo wprowadza wymóg weryfikacji organizacji przed uzyskaniem dostępu do zaawansowanych funkcji oraz niektórych modeli. Weryfikacja obejmuje m.in. konieczność przedstawienia dokumentów potwierdzających tożsamość oraz dane organizacyjne.

Integracja GitHuba z systemem ChatGPT Deep Research to wyraźny znak czasu – AI coraz mocniej przenika nie tylko do środowiska użytkowników końcowych, ale także do codziennej pracy profesjonalistów. W sposób zautomatyzowany i kontekstowy wspiera analizę, planowanie oraz wdrażanie oprogramowania. Dla firm technologicznych, studiów deweloperskich, startupów oraz środowisk akademickich to kolejny argument, by zainwestować w rozwój kompatybilnych narzędzi i kadr zdolnych do pracy z AI nowej generacji.