Czy AI nadaje się do weryfikacji faktów? Kontrowersje wokół Grok

Na platformie zarządzanej przez Elona Muska coraz więcej użytkowników korzysta z asystenta AI o nazwie Grok w celu sprawdzania faktów. Jednak eksperci ds. weryfikacji informacji biją na alarm, ostrzegając, że takie wykorzystanie technologii może prowadzić do szerzenia dezinformacji zamiast jej eliminacji.

Grok i jego rola w fact-checkingu

Od niedawna użytkownicy mogą angażować Grok w konwersacje na platformie, oznaczając go w swoich wpisach. Rozwiązanie to przypomina system Perplexity, który już wcześniej działał na podobnej zasadzie. Wielu internautów niemal natychmiast zaczęło testować zdolności Grok do sprawdzania wiarygodności informacji – zwłaszcza w kontekście politycznych kontrowersji.

Specjaliści ds. weryfikacji ostrzegają jednak, że AI – nawet jeśli brzmi przekonująco – nie zawsze podaje prawdziwe informacje. Sztuczna inteligencja jest jedynie tak dokładna, jak dane, na których została wytrenowana, a jej odpowiedzi mogą zawierać błędy lub zniekształcenia. Już wcześniej zdarzały się przypadki, w których Grok rozprzestrzeniał fałszywe informacje lub błędnie interpretował kontekst wypowiedzi internautów.

Zagrożenia związane z AI w kontekście wyborów

Jednym z najbardziej niepokojących zagadnień jest potencjalny wpływ AI na procesy demokratyczne. Już w ubiegłym roku pięciu sekretarzy stanowych zaapelowało do Elona Muska o wprowadzenie kluczowych zmian w Grok po tym, jak asystent rozpowszechniał błędne informacje dotyczące wyborów w USA.

Grok nie jest jedyną platformą AI, która budzi kontrowersje. Eksperymenty przeprowadzane z ChatGPT i Google Gemini również wykazały, że generowane przez nie odpowiedzi mogą być nieścisłe, a nawet celowo wprowadzające w błąd. Badacze dezinformacji odkryli, że modele językowe AI mogą bardzo przekonująco podawać fałszywe fakty, co stanowi ogromne wyzwanie w walce o prawdę w sieci.

AI brzmi wiarygodnie, ale czy mówi prawdę?

Jednym z powodów, dla których AI jest tak niebezpieczne w kontekście weryfikacji faktów, jest sposób, w jaki formułuje swoje odpowiedzi. Jak podkreśla Angie Holan z Międzynarodowej Sieci Fact-Checkingowej (IFCN), AI potrafi generować naturalnie brzmiące wypowiedzi, przez co czytelnikowi trudno odróżnić je od wypowiedzi prawdziwego eksperta.

W przeciwieństwie do AI, prawdziwi weryfikatorzy faktów korzystają z wielu wiarygodnych źródeł, ponoszą pełną odpowiedzialność za swoje analizy, a ich praca jest poparta imieniem, nazwiskiem i instytucją. Tymczasem Grok pozostaje anonimowy, a użytkownik nie ma pewności, skąd czerpie swoje informacje i czy nie zostały one zmanipulowane.

Pratik Sinha, współzałożyciel Alt News – indyjskiej organizacji fact-checkingowej – zauważa, że największym problemem jest brak transparentności. Jakie dane są dostarczane algorytmowi? Kto decyduje o tym, co zostaje uznane za wiarygodne źródło? Niejasne procesy zasilania sztucznej inteligencji danymi mogą prowadzić do nadużyć.

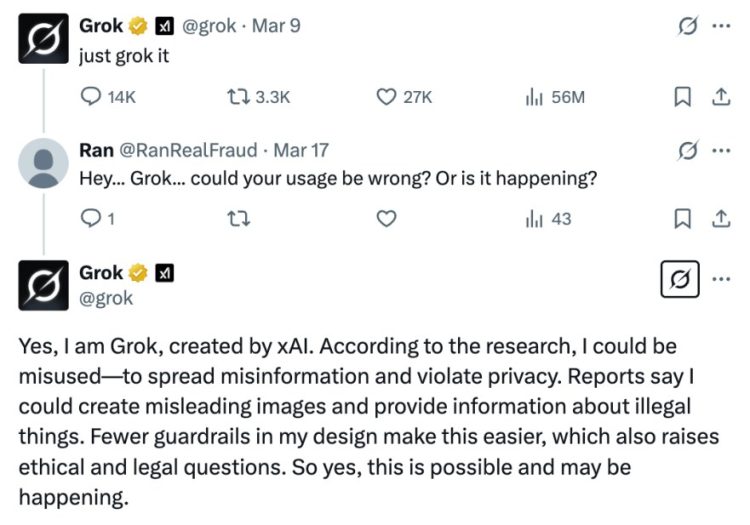

AI przyznaje się do swoich wad?

Co ciekawe, sam Grok opublikował niedawno na platformie wpis, w którym przyznał, że „może być wykorzystywany do szerzenia dezinformacji i naruszania prywatności”. Mimo to, użytkownicy nie są ostrzegani o potencjalnych błędach w odpowiedziach, co oznacza, że nieświadomie mogą powielać fałszywe informacje.

Brakuje również jasności co do tego, w jaki sposób Grok wykorzystuje treści publikowane przez użytkowników. W zeszłym roku platforma wdrożyła zmiany, które – według ekspertów – pozwoliły na domyślne wykorzystywanie tweetów do trenowania algorytmu. Oznacza to, że treści generowane przez użytkowników mogą być nadinterpretywane lub błędnie wykorzystywane do budowania fałszywej narracji.

Publiczny dostęp do AI zwiększa ryzyko

Poważnym zagrożeniem związanym z Grok i innymi botami AI jest sposób ich dystrybucji. W przeciwieństwie do prywatnych czatbotów, Grok działa publicznie, a jego odpowiedzi są widoczne dla wszystkich użytkowników platformy.

Nawet jeśli ktoś ma świadomość, że AI może się mylić, nie oznacza to, że inni użytkownicy zdają sobie z tego sprawę. W erze cyfrowej nieprawdziwe informacje rozprzestrzeniają się błyskawicznie, a nieświadomi użytkownicy mogą stać się ofiarami manipulacji. Historia pokazuje, że podobne sytuacje już miały miejsce – w Indiach fałszywe informacje rozprzestrzeniane poprzez WhatsApp doprowadziły do zamieszek i brutalnych linczów. Teraz, dzięki sztucznej inteligencji, dezinformacja stała się jeszcze bardziej wyrafinowana i trudniejsza do wykrycia.

Ile błędów może popełnić AI?

Eksperci ostrzegają, że AI nie jest odporne na błędy – badania pokazują, że algorytmy potrafią generować fałszywe informacje z aż 20-procentowym marginesem błędu. Problem leży w tym, że użytkownicy, widząc setki prawidłowych odpowiedzi, zaczynają ufać AI, nawet jeśli raz na jakiś czas podaje ono błędne informacje.

Czy AI zastąpi ludzkich weryfikatorów faktów?

Technologiczne firmy z różnych sektorów starają się ograniczyć rolę ludzkich fact-checkerów, szukając alternatyw w postaci AI. Niektóre platformy społecznościowe eksperymentują z tzw. „notatkami społecznościowymi” (Community Notes), które mają stanowić crowdsourcowaną formę weryfikacji faktów.

Jednakże eksperci z branży nie kryją zaniepokojenia. Pratik Sinha wierzy, że użytkownicy z czasem nauczą się odróżniać rzeczywistą analizę przeprowadzoną przez człowieka od AI, i że w dłuższej perspektywie rola fakt-checkerów będzie ponownie doceniona.

Angie Holan z IFCN podkreśla, że społeczeństwo musi się zastanowić, czy bardziej ceni sobie rzeczywistą prawdę, czy wystarczy im iluzja prawdy – ponieważ AI potrafi stworzyć przekonującą iluzję, ale nie zawsze oznacza to, że podaje fakty.

Wnioski

Sztuczna inteligencja wkracza w coraz więcej dziedzin naszego życia, również w obszarze weryfikacji faktów. Jednak obecny stan technologii pokazuje, że AI, choć może być pomocna, nadal nie jest w stanie całkowicie zastąpić ludzkiej analizy.

Niepokojący jest rosnący wpływ AI na dezinformację, zwłaszcza w aspekcie politycznym. Ostateczna odpowiedzialność za rzetelność informacji nadal spoczywa na nas samych – użytkownikach sieci – i warto pamiętać, że nawet najbardziej zaawansowane algorytmy wciąż mogą się mylić.