DeepSeek-R1 to zaawansowany model sztucznej inteligencji, którego główną siłą są wyjątkowe zdolności wnioskowania. W przeciwieństwie do klasycznych modeli generujących bezpośrednie odpowiedzi, DeepSeek-R1 wykorzystuje wieloetapowe procesy wnioskowania, takie jak analiza łańcuchowa, osiąganie konsensusu czy prowadzenie wyszukiwań, aby wygenerować najbardziej trafne odpowiedzi dla zadanego zapytania. To podejście zyskuje popularność dzięki rosnącym możliwościom nowoczesnych systemów obliczeniowych.

Nowa era dzięki testowemu skalowaniu obliczeń

Proces, w którym model sztucznej inteligencji wielokrotnie analizuje problem, aby dojść do najlepszego rozwiązania, jest znany jako skalowanie obliczeń w trakcie testowania. DeepSeek-R1 jest doskonałym przykładem wykorzystania tych zasad, co podkreśla jak istotna jest przyspieszona moc obliczeniowa dla modeli AI na potrzeby agentów samouczących się (agentic AI). Im bardziej model może „przemyśleć” dany problem, tym więcej generuje tokenów i zwiększa długość procesu tworzenia odpowiedzi, co przekłada się na jakość jego analiz. Aby osiągnąć takie rezultaty, konieczne są wyspecjalizowane środowiska obliczeniowe o dużej skali i wysokiej wydajności.

DeepSeek-R1 wyróżnia się najwyższą dokładnością w zadaniach wymagających logicznego wnioskowania, rozwiązywania problemów matematycznych, kodowania i zaawansowanego rozumienia języka. Jednocześnie model ten jest zaprojektowany tak, aby zachować wysoką efektywność procesów wnioskowania i analizy.

Udostępnienie modelu dla twórców i firm

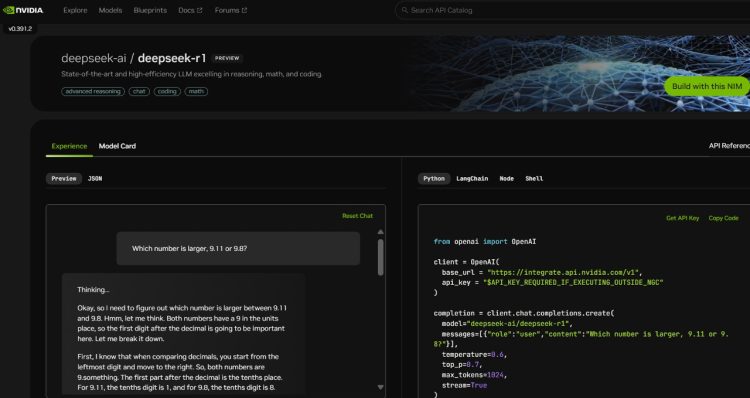

Model DeepSeek-R1, który opiera się na aż 671 miliardach parametrów, jest obecnie dostępny w ramach wortalu NVIDIA NIM Microservice jako podgląd technologiczny. Ten system pozwala na osiągnięcie imponującej prędkości generowania wynoszącej nawet 3 872 tokeny na sekundę na jednej jednostce NVIDIA HGX H200. Tego typu osiągnięcia są możliwe dzięki zaawansowanym optymalizacjom sprzętowym i programowym.

Deweloperzy mogą już teraz testować możliwości tego modelu poprzez specjalnie zaprojektowany interfejs API. Oczekuje się, że model wkrótce zostanie udostępniony jako w pełni funkcjonalna usługa NIM Microservice do pobrania w ramach platformy oprogramowania NVIDIA AI Enterprise. Dzięki temu użytkownicy będą mogli rozpocząć prace nad personalizowanymi agentami AI w sposób prosty i bezpieczny, jednocześnie zachowując pełną kontrolę nad danymi.

Microserwis NIM jest kompatybilny z przemysłowymi standardami API, co pozwala firmom na jego wdrożenia na dowolnej wybranej infrastrukturze akcelerowanej obliczeniowo. Korzystając z rozwiązań NVIDIA AI Foundry oraz oprogramowania NeMo, przedsiębiorstwa mogą również tworzyć dostosowane do swoich potrzeb wersje DeepSeek-R1, aby wspierać specjalistycznych agentów AI w określonych, niszowych zadaniach.

Potęga DeepSeek-R1 w liczbach

DeepSeek-R1 to model oparty na architekturze tzw. mieszanki ekspertów (Mixture-of-Experts, MoE), co oznacza, że korzysta z podsystemów wyspecjalizowanych w różnych zadaniach analizy. Model ten składa się z imponujących 671 miliardów parametrów, co stanowi dziesięciokrotnie większą ilość niż wiele popularnych modeli open-source. Dodatkowo obsługuje kontekst wejściowy aż do 128 000 tokenów, co jest kluczowe dla obsługi zadań o wysokiej złożoności.

Każda warstwa DeepSeek-R1 składa się z 256 ekspertów, a każdy token podczas przetwarzania jest poddawany analizie przez ośmiu z nich jednocześnie. Aby zapewnić rzeczywiste odpowiedzi w czasie rzeczywistym, konieczne jest wykorzystanie wielu procesorów graficznych (GPU) o wysokiej mocy obliczeniowej, połączonych siecią o dużej przepustowości i niskim opóźnieniu. Dzięki zastosowaniu architektury FP8 Transformer Engine w warstwach modelu oraz wykorzystaniu przepustowości 900 GB/s w komunikacji między ekspertami, DeepSeek-R1 może osiągać wyjątkową wydajność obliczeniową.

Wydajność nowej generacji

Pełne wykorzystanie mocy obliczeniowej GPU jest kluczowe w przypadku zaawansowanych modeli AI. Nowa generacja architektury NVIDIA Blackwell znacząco podniesie skalę możliwości modeli, takich jak DeepSeek-R1. Dzięki nowoczesnym Tensor Core piątej generacji, systemy oparte na Blackwell mogą osiągać aż do 20 petaflopów mocy obliczeniowej FP4, a także zoptymalizowaną komunikację między 72 procesorami GPU dzięki NVLink.

Rozpocznij pracę z DeepSeek-R1 już dziś

Deweloperzy zainteresowani testowaniem i wdrażaniem modelu mogą już dziś zapoznać się z możliwościami DeepSeek-R1 poprzez platformę NVIDIA NIM Microservice. Wysoka efektywność modelu oraz narzędzia do jego personalizacji sprawiają, że może on stanowić kluczowy element systemów opartych na agentic AI w przedsiębiorstwach. Dzięki prostocie w obsłudze i możliwości wdrożenia na wybranej infrastrukturze, DeepSeek-R1 spełnia wymagania najbardziej zaawansowanych projektów AI.