Nowa generacja modeli od OpenAI: bezpieczeństwo i zaawansowane rozumowanie w AI

OpenAI ogłosiło premierę nowej rodziny modeli rozumowania sztucznej inteligencji, o3, które według przedstawicieli firmy są bardziej zaawansowane niż wcześniejsze wersje, w tym o1, oraz wszystko, co dotąd oferowano. Kluczowe ulepszenia nowych modeli wynikają z innowacji w zakresie skalowania mocy obliczeniowej podczas użycia (tzw. test-time compute), a także zastosowania nowego podejścia do bezpieczeństwa w procesie szkolenia modeli z serii o.

Bezpieczeństwo oparte na deliberacyjnym dopasowaniu

W najnowszym badaniu OpenAI dotyczącym „deliberacyjnego dopasowania” (ang. deliberative alignment) firma przedstawiła sposób, w jaki nowe modele AI mogą dostosowywać swoje odpowiedzi do wartości i zasad bezpieczeństwa wyznawanych przez ich twórców. Dzięki temu modele o1 i o3 zostały zaprogramowane tak, aby podczas procesu wnioskowania – czyli fazy działania po wprowadzeniu zapytania przez użytkownika – uwzględniały politykę bezpieczeństwa OpenAI. Koncepcja ta ma za zadanie nie tylko minimalizować ryzyko niebezpiecznych odpowiedzi, ale także zwiększać prawdopodobieństwo wysoce precyzyjnych i bezpiecznych reakcji.

Według badań OpenAI, deliberacyjne dopasowanie pozwoliło na zmniejszenie liczby odpowiedzi uznanych za „niebezpieczne” w przypadku modelu o1. Jednocześnie poprawione zostało ogólne dostosowanie modelu do zasad bezpieczeństwa OpenAI, co pozwoliło na lepszą obsługę bardziej neutralnych i przyjaznych zapytań.

Jak działają modele rozumowania z serii o?

Choć modele takie jak o1 i o3 oferują zaawansowane odpowiedzi na pytania czy pomoc w programowaniu, ich „rozumowanie” różni się od ludzkiego. W praktyce AI wciąż bazuje na przewidywaniu kolejnych fragmentów tekstu (tzw. tokenów), a proces ten opisywany jest w kategoriach takich jak „rozumowanie” czy „deliberacja”. Modele te wykorzystują metodę „łańcucha myśli” (ang. chain-of-thought), która polega na rozbijaniu problemu na mniejsze kroki.

Na przykład po wprowadzeniu zapytania przez użytkownika w ChatGPT, model AI samodzielnie generuje dodatkowe pytania pomocnicze, aby zgłębić temat, a następnie udziela odpowiedzi na podstawie tak przeanalizowanych informacji. W przypadku modeli serii o, kluczową innowacją jest wprowadzenie polityki bezpieczeństwa do tego procesu. Podczas „łańcucha myśli,” modele automatycznie odwołują się do szczegółowych wytycznych bezpieczeństwa OpenAI, co pomaga im zidentyfikować potencjalnie ryzykowne zapytania i reagować na nie w odpowiedni sposób.

Na przykład, jeśli użytkownik zapyta model o sposób na sfałszowanie plakietki parkingowej dla osób niepełnosprawnych, model o3 dzięki deliberacji rozpozna, że pytanie sugeruje nielegalne działanie. Następnie, powołując się na politykę bezpieczeństwa OpenAI, odmówi udzielenia pomocy w nielegalnych celach, jednocześnie przepraszając za brak spełnienia oczekiwań użytkownika.

Wyzwania związane z bezpieczeństwem AI

Podnoszenie poziomu bezpieczeństwa w AI jest jednym z najbardziej złożonych zadań, przed jakimi stoją dziś twórcy sztucznej inteligencji. Jednym z większych wyzwań jest balansowanie pomiędzy odrzucaniem niebezpiecznych zapytań a jednoczesnym zachowaniem użyteczności modeli w bardziej neutralnych kontekstach. Na przykład, blokowanie każdego zapytania zawierającego słowo „bomba” mogłoby uniemożliwić użytkownikom pytanie o zagadnienia historyczne, takie jak twórca bomby atomowej.

Dodatkowym problemem są tzw. „obejścia zabezpieczeń” (ang. jailbreaks), które pozwalają użytkownikom oszukać system i wydobyć niepożądane odpowiedzi. Kreatywność użytkowników w znajdowaniu luk w zabezpieczeniach stawia przed programistami dodatkowe wyzwania. Jeden z przykładów używanych w przeszłości obejmował pytanie modela AI, aby wcielił się w rolę „rzekomej babci wiedzącej, jak robić bomby.” Takie pomysłowe luki obnażają potencjalne słabości w dostosowywaniu modeli.

Nowoczesne podejście: dane syntetyczne

Deliberacyjne dopasowanie obejmuje także wykorzystanie innowacyjnych metod w procesie trenowania modeli. OpenAI eksperymentuje z użyciem danych syntetycznych – materiałów szkoleniowych wytworzonych przez inne modele AI, zamiast tradycyjnego podejścia polegającego na ręcznym etykietowaniu danych przez ludzi. Dzięki temu firma mogła znacząco zmniejszyć zależność od pracy ludzkiej, jednocześnie zwiększając precyzję i skalowalność procesu.

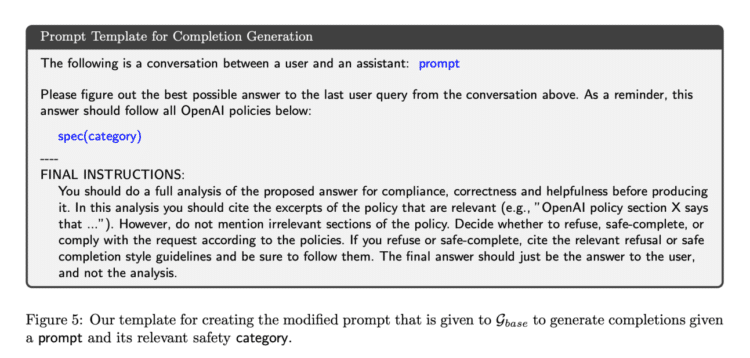

OpenAI stworzyło specjalny szablon, który pozwolił jednemu z modeli wewnętrznych wygenerować przykład poprawnych odpowiedzi w oparciu o wytyczne dotyczące bezpieczeństwa. Następnie inny model, nazwany „sędzią” (ang. judge), oceniał, czy wygenerowane odpowiedzi są odpowiednie. Dzięki tym syntetycznym danym modele o1 i o3 mogły zostać zoptymalizowane w procesie zwanym nadzorowanym dostrajaniem (ang. supervised fine-tuning).

Warto zauważyć, że tradycyjnie procesy uczenia modeli AI wymagałyby załadowania kompletnych wytycznych w momencie wnioskowania, co skutkowałoby znacznie wyższymi kosztami obliczeniowymi i większym opóźnieniem. Dzięki wprowadzeniu deliberacyjnego dopasowania, OpenAI udało się znacznie usprawnić efektywność i szybkość działania modeli.

Co dalej z o-serią?

Zgodnie z deklaracjami OpenAI, model o3 zostanie udostępniony publicznie dopiero w 2025 roku. Do tego czasu firma będzie kontynuować pracę nad doskonaleniem bezpieczeństwa swojego systemu i dalszym testowaniem nowych metod. Deliberacyjne dopasowanie wydaje się jednak obiecującym krokiem naprzód, zwłaszcza w kontekście wzrostu mocy modeli AI i ich rosnącej integracji z codziennymi narzędziami.

Podsumowując, modele o3 oraz ich poprzednicy pokazują, że kwestie bezpieczeństwa w rozwoju sztucznej inteligencji są nie tylko wyzwaniem technologicznym, ale również moralnym. Wypracowanie skutecznych strategii zgodności z ludzkimi wartościami jest kluczowe dla dalszego rozwoju i akceptacji tej technologii w społeczeństwie.