Laptopy i komputery stacjonarne wyposażone w generatywną sztuczną inteligencję (AI) otwierają nowe możliwości w dziedzinach takich jak gaming, tworzenie treści, produktywność oraz rozwój technologii. Obecnie ponad 600 aplikacji i gier dla systemu Windows korzysta z AI na ponad 100 milionach komputerów wyposażonych w karty graficzne GeForce RTX na całym świecie. Technologia ta oferuje szybkie, niezawodne i niskolatencyjne działanie, co znacząco wpływa na jakość pracy i rozrywki użytkowników.

Podczas konferencji Microsoft Ignite ogłoszono współpracę NVIDII i Microsoftu, której celem jest udostępnienie nowych narzędzi dla deweloperów. Umożliwiają one szybkie tworzenie i optymalizację aplikacji bazujących na sztucznej inteligencji na komputerach z technologią RTX AI. Dzięki temu narzędzia te pozwalają programistom gier i aplikacji na wykorzystanie mocy kart graficznych RTX w celu przyspieszenia złożonych procesów AI, takich jak agenci wirtualni, asystenci aplikacji czy cyfrowi ludzie.

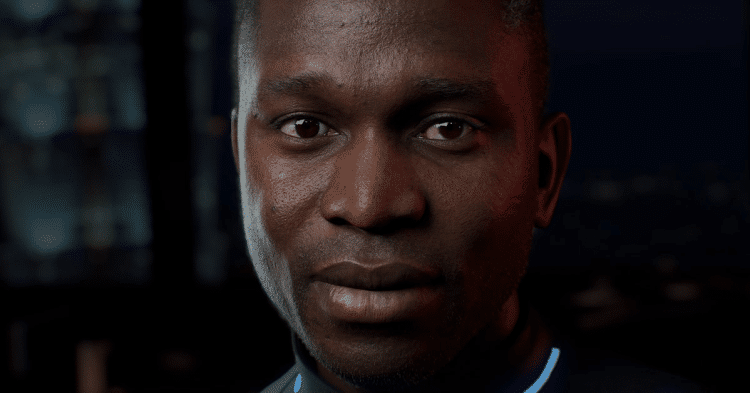

Cyfrowi ludzie zasilani technologią RTX AI i multimodalnymi modelami językowymi

NVIDIA ACE to zestaw technologii cyfrowych ludzi, które dają życie wirtualnym agentom, asystentom i awatarom. Aby osiągnąć bardziej zaawansowany poziom interakcji, cyfrowi ludzie muszą posiadać zdolność wizualnego postrzegania świata w sposób podobny do ludzi. To wymaga zaawansowanej technologii, która pozwala im z większą precyzją rozumieć otoczenie i kontekst sytuacji.

Dzięki multimodalnym małym modelom językowym NVIDIA, cyfrowi ludzie mogą przetwarzać zarówno tekst, jak i obrazy, a także wykazywać się zdolnościami w zakresie symulacji ról. Te modele są zoptymalizowane pod kątem szybkiego reagowania, co czyni ich interakcje bardziej realistycznymi i płynnymi. Na przykład model NVIDIA Nemovision-4B-Instruct, oparty na frameworkach NVIDIA VILA i NeMo, został zoptymalizowany do pracy na GPU RTX, co pozwala na osiągnięcie wysokiej dokładności i wydajności przy minimalnym zużyciu zasobów.

Dodatkowo, NVIDIA wprowadza rodzinę modeli Mistral NeMo Minitron 128k Instruct, które zostały zaprojektowane z myślą o efektywnej interakcji z cyfrowymi ludźmi. Modele te dostępne będą w wersjach o różnej liczbie parametrów (8B, 4B i 2B), co pozwala na znalezienie idealnego balansu między szybkością, zużyciem pamięci a dokładnością. Co więcej, są one zoptymalizowane do działania na urządzeniach o niskim poborze mocy, co zwiększa ich wszechstronność i kompatybilność z różnymi środowiskami programistycznymi.

Przyspieszenie generatywnej AI dzięki NVIDIA TensorRT Model Optimizer

Deweloperzy aplikacji AI, którzy chcą uruchamiać swoje modele lokalnie na komputerach PC, często napotykają na ograniczenia związane z pamięcią i mocą obliczeniową. Kluczowe jest także udostępnienie ich szerokiemu gronu użytkowników przy zachowaniu wysokiej dokładności działania. Aby sprostać tym wyzwaniom, NVIDIA wprowadziła aktualizacje narzędzia TensorRT Model Optimizer (ModelOpt), które wspierają optymalizację modeli AI z myślą o środowiskach Windows i ONNX Runtime.

Dzięki nowym funkcjom ModelOpt, modele AI mogą być optymalizowane do formatu ONNX, co umożliwia ich efektywne wdrażanie z wykorzystaniem takich dostawców GPU jak CUDA, TensorRT czy DirectML. Nowe algorytmy kwantyzacji, takie jak INT4-Activation Aware Weight Quantization, pozwalają znacząco zmniejszyć rozmiar modeli, poprawiając jednocześnie ich przepustowość na kartach graficznych RTX. W praktyce oznacza to nawet 2,6-krotne zmniejszenie zużycia pamięci w porównaniu z modelami FP16, co przyspiesza ich działanie przy minimalnym spadku dokładności.

Możliwości te otwierają nowe perspektywy dla rozwoju aplikacji AI, które mogą działać na szerokiej gamie urządzeń, od komputerów stacjonarnych po serwery w chmurze. Rozwiązania takie jak NVIDIA Blackwell i Azure zapewniają użytkownikom jeszcze większą elastyczność i moc w codziennej pracy z technologią AI.